Установка и настройка отказоустойчивого кластера. — различия между версиями

Wikiadmin (обсуждение | вклад) (→PG) |

Wikiadmin (обсуждение | вклад) (→Инструкция по установке Wine и Winetricks в Linux) |

||

| (не показано 40 промежуточных версий этого же участника) | |||

| Строка 284: | Строка 284: | ||

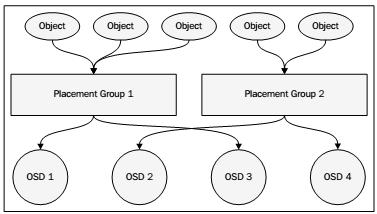

Для балансировки доступных аппаратных ресурсов необходимо назначать правильное число групп размещения. Число групп размещения должно меняться в зависимости от число OSD в кластере. Следующая таблица предлагаемых групп размещений выполнена разработчиками Ceph: | Для балансировки доступных аппаратных ресурсов необходимо назначать правильное число групп размещения. Число групп размещения должно меняться в зависимости от число OSD в кластере. Следующая таблица предлагаемых групп размещений выполнена разработчиками Ceph: | ||

| − | { | + | {|class="wikitable" |

| − | |class="wikitable" | ||

!Число OSD | !Число OSD | ||

!Число PG | !Число PG | ||

| Строка 306: | Строка 305: | ||

===Pools=== | ===Pools=== | ||

Пулы Ceph аналогичны разделам жесткого диска. Мы можем создать множество пулов в кластере Ceph для разделения хранимых данных. Например, пул с названием accounting может хранить данные всего подразделения бухгалтерского учета, а другой пул может хранить данные о персонале компании. При создании пула необходимо назначение числа групп размещения. При начальной настройке Ceph создаются три пула по умолчанию. Это data, metadata и rbd. Удаление пула навсегда удалит все хранимые объекты. | Пулы Ceph аналогичны разделам жесткого диска. Мы можем создать множество пулов в кластере Ceph для разделения хранимых данных. Например, пул с названием accounting может хранить данные всего подразделения бухгалтерского учета, а другой пул может хранить данные о персонале компании. При создании пула необходимо назначение числа групп размещения. При начальной настройке Ceph создаются три пула по умолчанию. Это data, metadata и rbd. Удаление пула навсегда удалит все хранимые объекты. | ||

| + | |||

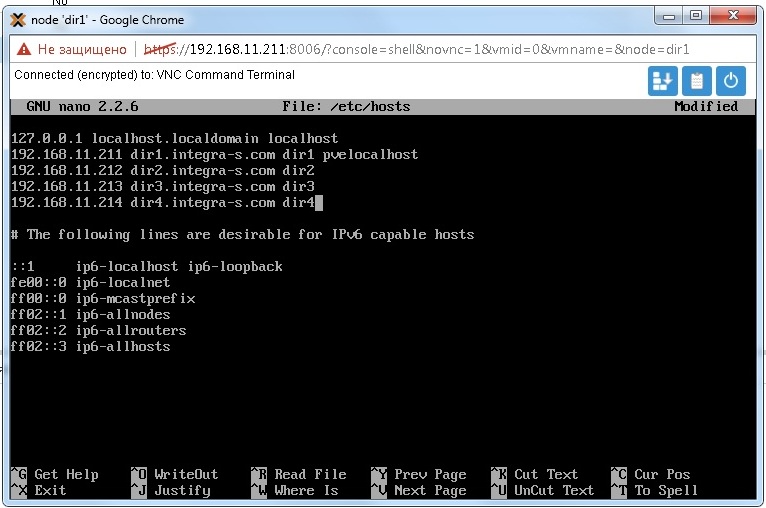

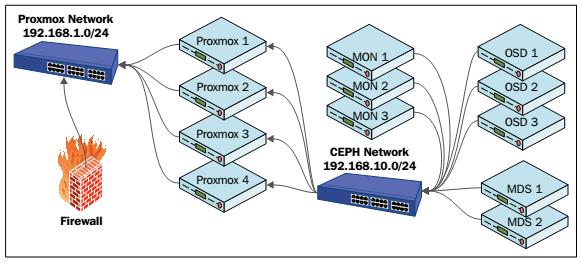

Следующий рисунок демонстрирует основы кластера Proxmox+Ceph | Следующий рисунок демонстрирует основы кластера Proxmox+Ceph | ||

| − | + | [[Файл:cl_7.jpg|центр|]] | |

| − | + | ||

| + | Предыдущий рисунок показывает узлы Proxmox, три узла монитора, три узла OSD и два узла MDS составляющие кластер Proxmox+Ceph. Заметим, что Ceph располагается в сети, которая отличается от общедоступной сети. В зависимости от установки числа репликаций все приходящие данные объектов должны записываться более одного раза. Это вызывает высокую потребность в пропускной способности. {Прим. пер.: еще большую нагрузку создают автоматическая балансировка, сохраняющая примерно равным процент заполнения всех OSD в кластере Ceph, и восстановление копий в случае выхода из строя некоего оборудования}. Выделяя Ceph в отдельную сетевую среду мы будем уверены, что сеть Ceph может полностью использовать всю полосу пропускания. | ||

| + | |||

| + | В более продвинутых кластерах третья сеть создается исключительно между узлами Ceph для репликаций кластера, тем самым еще больше улучшая производительность. В Proxmox VE 3.4. один и тот же узел может использоваться и для Proxmox, и для Ceph. Это предоставляет больший способ управляемости всеми узлами из одного графического интерфейса Proxmox. Не рекомендуется размещать виртуальные машины Proxmox на узле который также настроен как Ceph. Во время повседневных операций узлы Ceph не потребляют больших объемов ресурсов подобных процессорам или памяти. Однако, когда Ceph переходит в режим балансировки вследствие отказа узла OSD возникают большие объемы реплицируемых данных, что требует больших объемов ресурсов. Если ресурсы совместно используются виртуальными машинами и Ceph, производительность значительно ухудшится. | ||

===Настройка основного хранилища=== | ===Настройка основного хранилища=== | ||

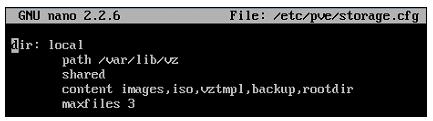

| − | + | Вы можете настроить хранилище в кластере Proxmox как с применением GUI, так и с помощью CLI. Настройка хранилища сохраняется в файле | |

| − | + | ||

| + | '''/etc/pve/storage.cfg.''' | ||

| + | |||

Вы можете изменить этот файл непосредственно чтобы добавить хранилища через графический интерфейс Proxmox, а настройки сохранятся автоматически. Следующий снимок экрана является файлом настроек хранилищ в том виде, как он возникает после чистой установки Proxmox: | Вы можете изменить этот файл непосредственно чтобы добавить хранилища через графический интерфейс Proxmox, а настройки сохранятся автоматически. Следующий снимок экрана является файлом настроек хранилищ в том виде, как он возникает после чистой установки Proxmox: | ||

| + | |||

| + | [[Файл:cl_8.jpg|центр|]] | ||

Настройка хранилищ обычно имеет следующий многострочный формат: | Настройка хранилищ обычно имеет следующий многострочный формат: | ||

| − | <type of storage> : <storage_id> | + | |

| − | <path_to_storage> | + | '''<type of storage> : <storage_id>''' |

| − | <enable/disable share> | + | |

| − | content types | + | '''<path_to_storage>''' |

| − | maxfiles <numeric value of maximum backups to keep> | + | |

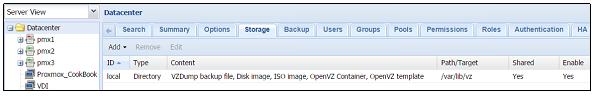

| − | На основании данной настройки существует локальное хранилище подключенное к кластеру Proxmox, причем все файлы будут сохраняться в каталоге /var/lib/vz. Данное хранилище может хранить типы содержания, включающие образы дисков, ISO, шаблоны контейнеров и файлы резервных копий. Хранилище будет хранить максимум три последних файла резервных копии. Следующий снимок экрана показывает хранилище из графического интерфейса Proxmox: | + | '''<enable/disable share>''' |

| + | |||

| + | '''content types''' | ||

| + | |||

| + | '''maxfiles <numeric value of maximum backups to keep>''' | ||

| + | |||

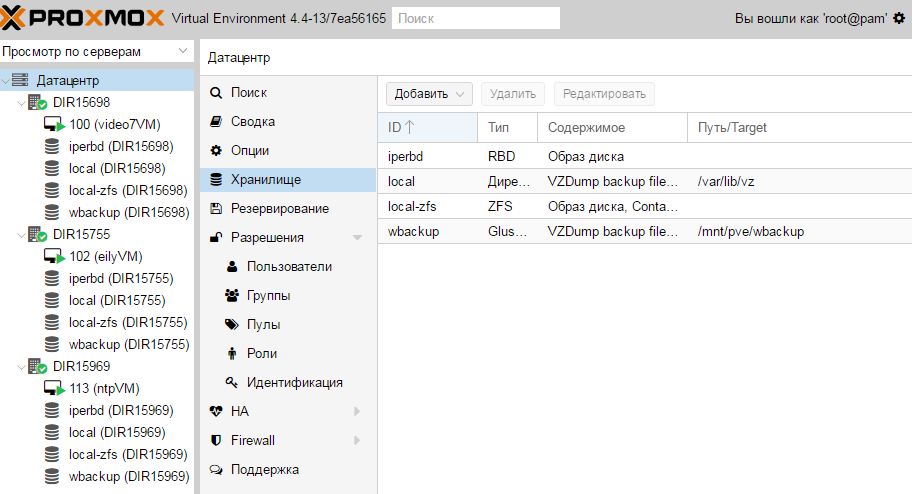

| + | На основании данной настройки существует локальное хранилище подключенное к кластеру Proxmox, причем все файлы будут сохраняться в каталоге '''/var/lib/vz'''. Данное хранилище может хранить типы содержания, включающие образы дисков, ISO, шаблоны контейнеров и файлы резервных копий. Хранилище будет хранить максимум три последних файла резервных копии. Следующий снимок экрана показывает хранилище из графического интерфейса Proxmox: | ||

| + | |||

| + | [[Файл:cl_9.jpg|центр|]] | ||

Изменение настройки хранилища не требует перезагрузки и вступает в действие немедленно. | Изменение настройки хранилища не требует перезагрузки и вступает в действие немедленно. | ||

| Строка 332: | Строка 347: | ||

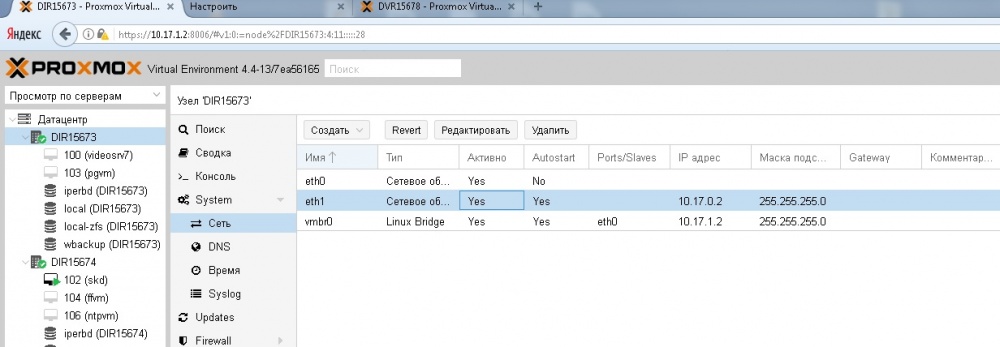

Добавляем внутреннюю сеть в веб-интерфейсе Proxmox для каждого из нодов (eth1) | Добавляем внутреннюю сеть в веб-интерфейсе Proxmox для каждого из нодов (eth1) | ||

| + | |||

| + | [[Файл:cl_10.jpg|центр|1000px|]] | ||

System – сеть | System – сеть | ||

| − | Перезагружаем каждую нод (сервер) два раза, должно быть yes в столбце «Активно» | + | [[Файл:cl_11.jpg|центр|]] |

| + | |||

| + | Перезагружаем каждую нод (сервер) '''два раза''', должно быть '''yes''' в столбце «Активно» | ||

===Для внутренней сети с использованием 10 Гб/с и резервированием (Linux bond)=== | ===Для внутренней сети с использованием 10 Гб/с и резервированием (Linux bond)=== | ||

====Вводная часть==== | ====Вводная часть==== | ||

| − | + | ||

| − | + | Для обеспечения отказоустойчивости и повышения пропускной способности сетевых интерфейсов сервера используется агрегация линков, так называемый bonding. Эта технология позволяет объединить два или более физических сетевых интерфейсов в один виртуальный. | |

====Типы агрегации (объединения) интерфейсов в Linux==== | ====Типы агрегации (объединения) интерфейсов в Linux==== | ||

| − | mode=0 (balance-rr) | + | '''mode=0 (balance-rr)''' |

| + | |||

Этот режим используется по-умолчанию, если в настройках не указано другое. balance-rr обеспечивает балансировку нагрузки и отказоустойчивость. В данном режиме пакеты отправляются "по кругу" от первого интерфейса к последнему и сначала. Если выходит из строя один из интерфейсов, пакеты отправляются на остальные оставшиеся.При подключении портов к разным коммутаторам, требует их настройки. | Этот режим используется по-умолчанию, если в настройках не указано другое. balance-rr обеспечивает балансировку нагрузки и отказоустойчивость. В данном режиме пакеты отправляются "по кругу" от первого интерфейса к последнему и сначала. Если выходит из строя один из интерфейсов, пакеты отправляются на остальные оставшиеся.При подключении портов к разным коммутаторам, требует их настройки. | ||

| − | mode=1 (active-backup) | + | |

| + | '''mode=1 (active-backup)''' | ||

| + | |||

При active-backup один интерфейс работает в активном режиме, остальные в ожидающем. Если активный падает, управление передается одному из ожидающих. Не требует поддержки данной функциональности от коммутатора. | При active-backup один интерфейс работает в активном режиме, остальные в ожидающем. Если активный падает, управление передается одному из ожидающих. Не требует поддержки данной функциональности от коммутатора. | ||

| − | mode=2 (balance-xor) | + | |

| + | '''mode=2 (balance-xor)''' | ||

| + | |||

Передача пакетов распределяется между объединенными интерфейсами по формуле ((MAC-адрес источника) XOR (MAC-адрес получателя)) % число интерфейсов. Один и тот же интерфейс работает с определённым получателем. Режим даёт балансировку нагрузки и отказоустойчивость. | Передача пакетов распределяется между объединенными интерфейсами по формуле ((MAC-адрес источника) XOR (MAC-адрес получателя)) % число интерфейсов. Один и тот же интерфейс работает с определённым получателем. Режим даёт балансировку нагрузки и отказоустойчивость. | ||

| − | mode=3 (broadcast) | + | |

| + | '''mode=3 (broadcast)''' | ||

| + | |||

Происходит передача во все объединенные интерфейсы, обеспечивая отказоустойчивость. | Происходит передача во все объединенные интерфейсы, обеспечивая отказоустойчивость. | ||

| − | mode=4 (802.3ad) | + | |

| + | '''mode=4 (802.3ad)''' | ||

| + | |||

Это динамическое объединение портов. В данном режиме можно получить значительное увеличение пропускной способности как входящего так и исходящего трафика, используя все объединенные интерфейсы. Требует поддержки режима от коммутатора, а так же (иногда) дополнительную настройку коммутатора. | Это динамическое объединение портов. В данном режиме можно получить значительное увеличение пропускной способности как входящего так и исходящего трафика, используя все объединенные интерфейсы. Требует поддержки режима от коммутатора, а так же (иногда) дополнительную настройку коммутатора. | ||

| − | mode=5 (balance-tlb) | + | |

| + | '''mode=5 (balance-tlb)''' | ||

| + | |||

Адаптивная балансировка нагрузки. При balance-tlb входящий трафик получается только активным интерфейсом, исходящий - распределяется в зависимости от текущей загрузки каждого интерфейса. Обеспечивается отказоустойчивость и распределение нагрузки исходящего трафика. Не требует специальной поддержки коммутатора. | Адаптивная балансировка нагрузки. При balance-tlb входящий трафик получается только активным интерфейсом, исходящий - распределяется в зависимости от текущей загрузки каждого интерфейса. Обеспечивается отказоустойчивость и распределение нагрузки исходящего трафика. Не требует специальной поддержки коммутатора. | ||

| − | |||

| − | |||

| − | |||

| + | '''mode=6 (balance-alb)''' | ||

| + | Адаптивная балансировка нагрузки (более совершенная). Обеспечивает балансировку нагрузки как исходящего (TLB, transmit load balancing), так и входящего трафика (для IPv4 через ARP). Не требует специальной поддержки коммутатором, но требует возможности изменять MAC-адрес устройства. | ||

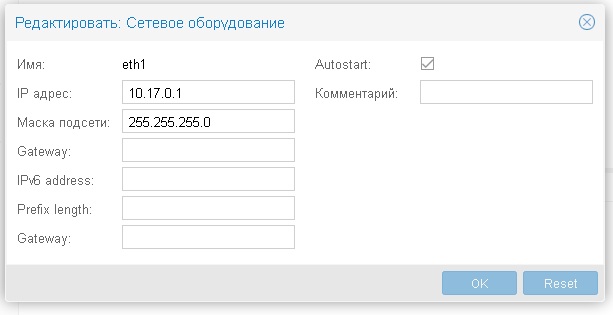

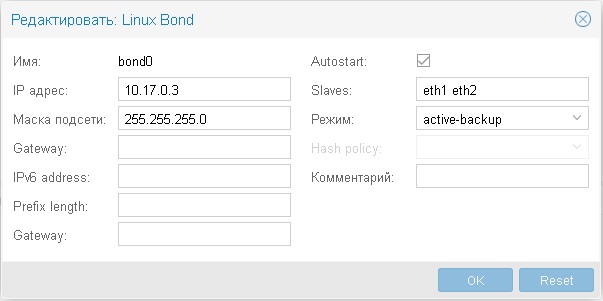

===Настройка Linux Bond=== | ===Настройка Linux Bond=== | ||

| − | 1 | + | 1. Добавить через веб морду |

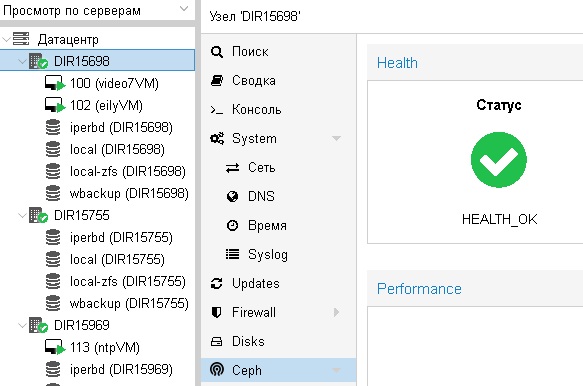

Datacenter-> node->System->Network | Datacenter-> node->System->Network | ||

| Строка 371: | Строка 400: | ||

Create Linux Bond | Create Linux Bond | ||

| + | [[Файл:cl_12.jpg|центр|]] | ||

| + | |||

| + | |||

| + | [[Файл:cl_13.jpg|центр|]] | ||

Обратите внимание eth1 eth2 в вашем случаем могут быть другими | Обратите внимание eth1 eth2 в вашем случаем могут быть другими | ||

| Строка 378: | Строка 411: | ||

Все заполняем и делаем restart через веб морду | Все заполняем и делаем restart через веб морду | ||

| − | + | 2. Добавляем в '''nano /etc/network/interfaces.new''' | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

bond_primary eth2 | bond_primary eth2 | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | в конец файла | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | 3. Должно выглядеть так, (eth's могут не совпадать) | |

| − | + | auto bond0 | |

| + | iface bond0 inet static | ||

| + | address 10.10.10.1 | ||

| + | netmask 255.255.255.0 | ||

| + | slaves eth1 eth2 | ||

| + | bond_miimon 100 | ||

| + | bond_mode active-backup | ||

| + | bond_primary eth2 | ||

| − | + | Сохраняем, перезагружаемся. | |

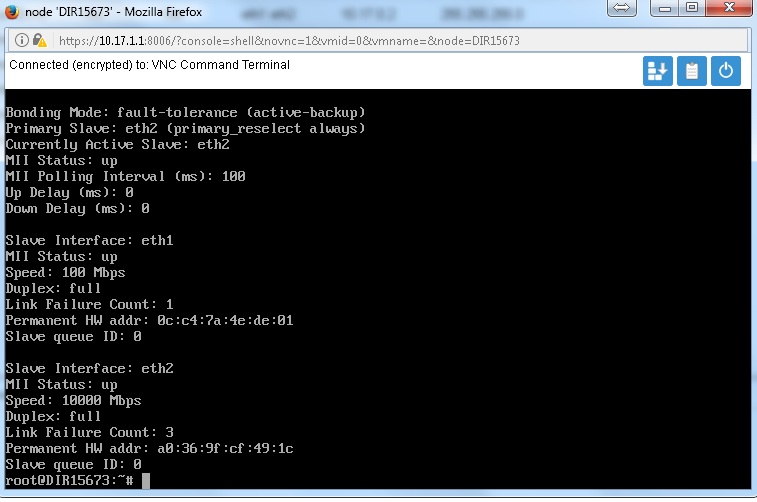

| − | + | Проверяем командой | |

| − | + | '''nano /etc/network/interfaces''' | |

| − | + | сохранилась ли строка '''bond_primary eth2''' в конце | |

| − | + | На 10 гб/с сетевых картах в Крыму '''eth2''' расположен дальше всех, последним сетевым входом, предпоследним является '''eth3'''. Будьте внимательны! | |

| − | + | Проверить активность портов можно командой | |

| − | |||

| − | # | + | '''<nowiki>#cat /proc/net/bonding/bond0</nowiki>''' |

| − | + | [[Файл:cl_14.jpg|центр|]] | |

| − | + | '''MII Status''' должно быть '''up''' | |

| − | + | Если down то пишем команду | |

| − | + | '''<nowiki>#ifup eth2</nowiki>''' | |

| − | + | (или же '''eth3''', смотря в какой интерфейс подключен кабель) | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| + | ===Общее для всех внутренних сетей === | ||

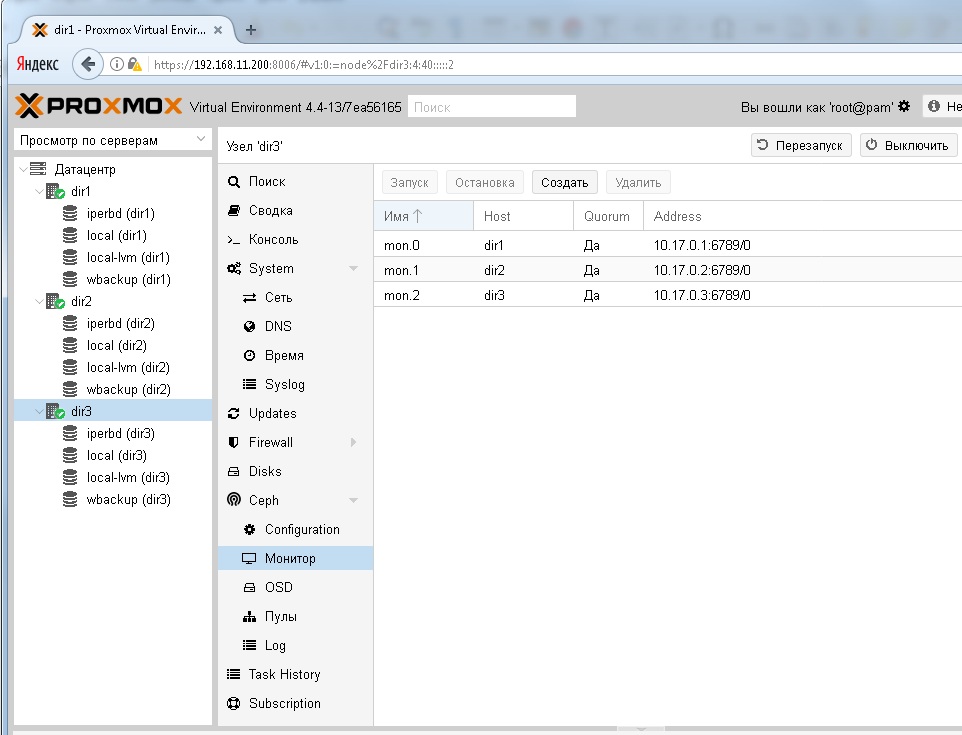

| + | На главной Ноде (dir1) пишем команду: | ||

| + | '''<nowiki>#pveceph init --network 10.17.0.0/24</nowiki>''' | ||

| + | ''(нужно помнить что 10.17.0.0/24 это для адресов 10.17.Х.Х с маской 255.255.255.0, в вашем случае может быть иначе)'' | ||

| + | Создание мониторов делаем через консоль, '''для каждого нода''' командой: | ||

| + | '''<nowiki>#pveceph createmon</nowiki>''' | ||

| + | Должны получить следующее: | ||

| + | [[Файл:cl_15.jpg|центр|]] | ||

| + | Далее подготавливаем HDD для OSD, для этого их необходимо перевести в GPT | ||

| + | в консоле пишем команду: | ||

| + | <nowiki>#fdisk /dev/sdc</nowiki> | ||

| + | g | ||

| + | w | ||

| + | Тоже самое проделываем для '''sdd''', и так на каждой Ноде | ||

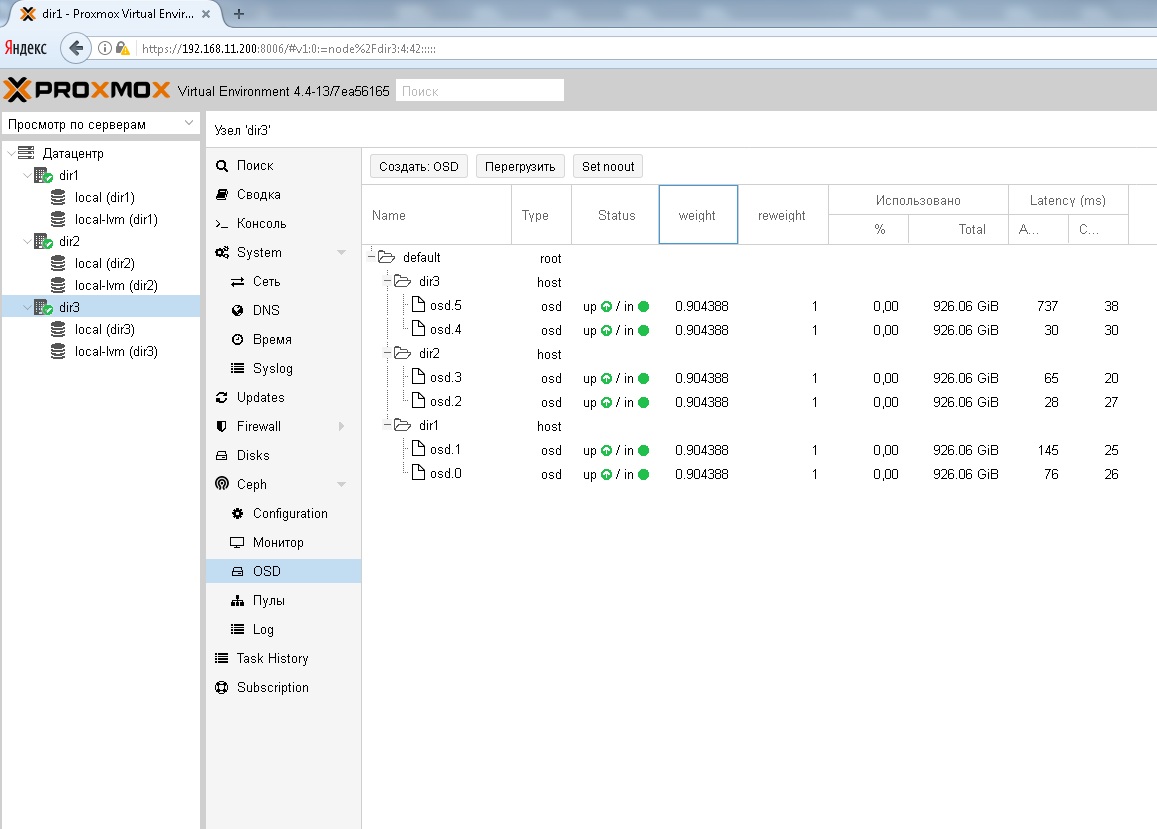

| + | После подготовки к созданию OSD, переходим в веб-интерфейсе в строку '''Ceph – OSD и нажимаем создать OSD''' | ||

| − | + | Выбираем '''sdc''' и в строке журналирования так же '''sdc''' | |

| − | + | Для '''sdd''' так же журналирование на '''sdd''' | |

| + | '''И так на каждой из нод.''' В итоге получаем 6 шт OSD | ||

| + | [[Файл:cl_16.jpg|центр|]] | ||

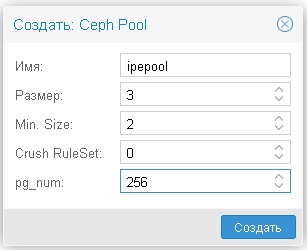

| + | Далее '''удаляем''' «Пул» и создаем новый с такими параметрами: | ||

| + | [[Файл:cl_17.jpg|центр|]] | ||

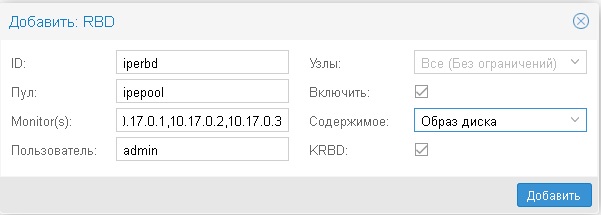

| + | '''Далее создаем RBD''' | ||

| + | '''Датацентр — Хранилище — добавить — RBD''' | ||

| − | + | [[Файл:cl_18.jpg|центр|]] | |

| − | + | ''Мониторы отделяем запятой без пробела'' | |

| − | + | Затем на '''любой''' из Нод через консоль делаем следующее: | |

| − | #mkdir ceph | + | <nowiki>#cd /etc/pve/priv/</nowiki> |

| − | + | <nowiki>#mkdir ceph</nowiki> | |

| − | #cp /etc/ceph/ceph.client.admin.keyring ceph/iperbd.keyring (используйте Табуляцию) | + | <nowiki>#cp /etc/ceph/ceph.client.admin.keyring ceph/iperbd.keyring</nowiki> (используйте Табуляцию) |

| − | |||

| − | |||

| + | где '''iperbd''' — это имя нашего RBD. | ||

==Создание Glusterfs== | ==Создание Glusterfs== | ||

| − | + | GlusterFS — это распределённая, параллельная, линейно масштабируемая файловая система с возможностью защиты от сбоев. С помощью InfiniBand RDMA или TCP/IP GlusterFS может объединить хранилища данных, находящиеся на разных серверах, в одну параллельную сетевую файловую систему. GlusterFS работает в пользовательском пространстве при помощи технологии FUSE, поэтому не требует поддержки со стороны ядра операционной системы и работает поверх существующих файловых систем (ext3, ext4, XFS, reiserfs и т. п.). | |

Проверить на главной ноде gluster всех трех нод, командой: | Проверить на главной ноде gluster всех трех нод, командой: | ||

| − | #gluster peer probe <dir1 name> | + | <nowiki>#gluster peer probe <dir1 name></nowiki> |

| − | + | <nowiki>#gluster peer probe <dir2 name></nowiki> | |

| − | #gluster peer probe <dir2 name> | + | <nowiki>#gluster peer probe <dir3 name></nowiki> |

| − | |||

| − | #gluster peer probe <dir3 name> | ||

На всех трех нодах проделываем следующие команды: | На всех трех нодах проделываем следующие команды: | ||

| − | #zfs create -o mountpoint=/media/gfs rpool/gfs | + | <nowiki>#zfs create -o mountpoint=/media/gfs rpool/gfs |

| − | + | #zfs set acltype=posixacl rpool/gfs | |

| − | #zfs set acltype=posixacl rpool/gfs | + | #zfs set atime=off rpool/gfs |

| − | + | #zfs set xattr=sa rpool/gfs | |

| − | #zfs set atime=off rpool/gfs | + | #zfs set overlay=on rpool/gfs</nowiki> |

| − | |||

| − | #zfs set xattr=sa rpool/gfs | ||

| − | |||

| − | #zfs set overlay=on rpool/gfs | ||

на всех нодах создаем папку wbackup командой: | на всех нодах создаем папку wbackup командой: | ||

| − | #mkdir -p /media/gfs/wbackup | + | <nowiki>#mkdir -p /media/gfs/wbackup</nowiki> |

| − | |||

Далее на главной ноде <dir1> пишем: | Далее на главной ноде <dir1> пишем: | ||

| − | #gluster volume create wbackup replica 3 dir1:/media/gfs/wbackup | + | <nowiki>#gluster volume create wbackup replica 3 dir1:/media/gfs/wbackup dir2:/media/gfs/wbackup dir3:/media/gfs/wbackup force (одной строкой)</nowiki> |

| − | dir2:/media/gfs/wbackup dir3:/media/gfs/wbackup force (одной строкой) | ||

Стартуем службу | Стартуем службу | ||

| − | #gluster volume start wbackup (на главной ноде) | + | <nowiki>#gluster volume start wbackup (на главной ноде)</nowiki> |

Проверяем на каждой ноде командой | Проверяем на каждой ноде командой | ||

| − | #gluster volume info | + | <nowiki>#gluster volume info</nowiki> |

| + | |||

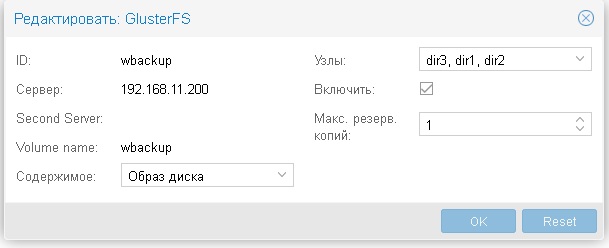

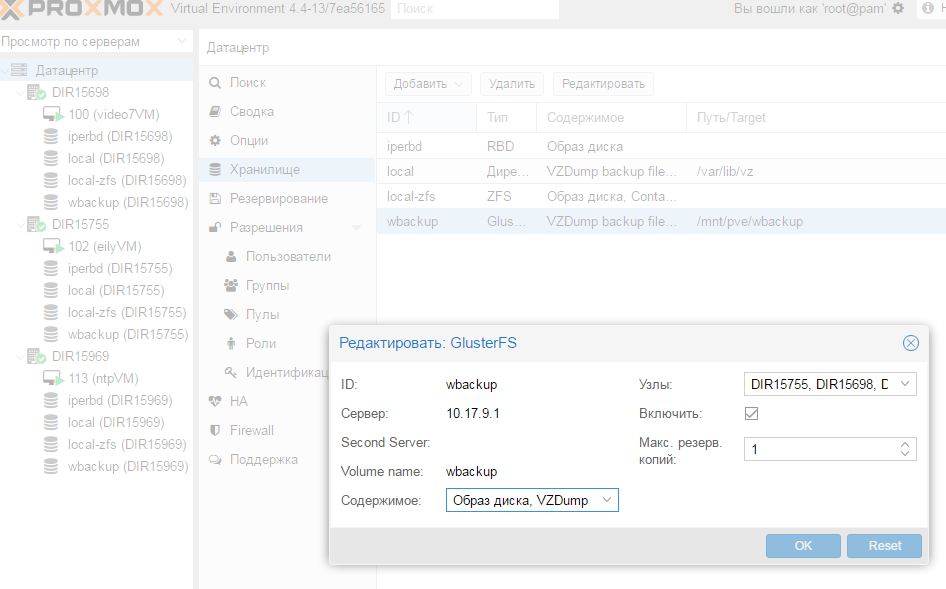

| + | Затем в веб-интерфейсе '''Датацентр — Хранилище — Добавить - GlusterFS''' | ||

| − | + | [[Файл:cl_19.jpg|центр|]] | |

Строки Volume name и Узлы брать из выпадающего списка, не вбивая самостоятельно! | Строки Volume name и Узлы брать из выпадающего списка, не вбивая самостоятельно! | ||

| Строка 529: | Строка 552: | ||

Если требуется удалить volume | Если требуется удалить volume | ||

| − | #gluster volume stop wbackup | + | <nowiki>#gluster volume stop wbackup |

| − | + | #gluster volume delete wbsckup | |

| − | #gluster volume delete wbsckup | + | #cd /media/glusterfs/wbackup |

| − | + | for I in ‘attr -lq .`; do setfattr -x trusted.$i .; done attr -lq ./</nowiki> | |

| − | #cd /media/glusterfs/wbackup | ||

| − | for I in ‘attr -lq .`; do setfattr -x trusted.$i .; done attr -lq ./ | ||

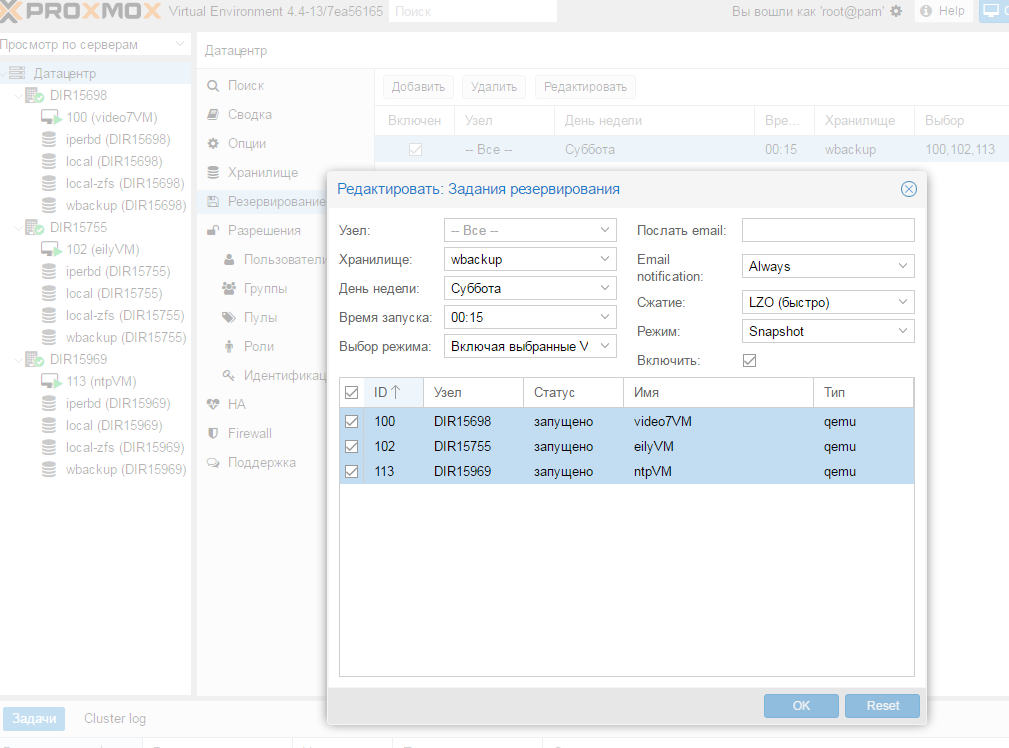

===Настройка резервирования=== | ===Настройка резервирования=== | ||

| − | 1 | + | 1. Настраиваем glusterfs |

| − | Datacenter → [wbackup/Glusterfs] → оставить только Content [VZDump backup file] → [OK] | + | '''Datacenter → [wbackup/Glusterfs] → оставить только Content [VZDump backup file] → [OK]''' |

Или в русскоязычном интерфейсе | Или в русскоязычном интерфейсе | ||

| − | Датацентр – Хранилище – wbackup – оставить только Образ диска [VZDump backup file] - [OK] | + | '''Датацентр – Хранилище – wbackup – оставить только Образ диска [VZDump backup file] - [OK]''' |

| − | |||

| − | |||

| + | [[Файл:cl_20.jpg|центр|]] | ||

| + | [[Файл:cl_21.jpg|центр|]] | ||

| − | Datacenter → Backup → [Add] → <Storage local> изменить на <Storage wbackup> настроить → [Create] | + | '''Datacenter → Backup → [Add] → <Storage local> изменить на <Storage wbackup> настроить → [Create]''' |

Или в русскоязычном интерфейсе | Или в русскоязычном интерфейсе | ||

| − | Датацентр – Резервирование – Добавить – < local> изменить на <wbackup> настроить расписание - [Create] | + | '''Датацентр – Резервирование – Добавить – < local> изменить на <wbackup> настроить расписание - [Create]''' |

| + | [[Файл:cl_22.png|центр|]] | ||

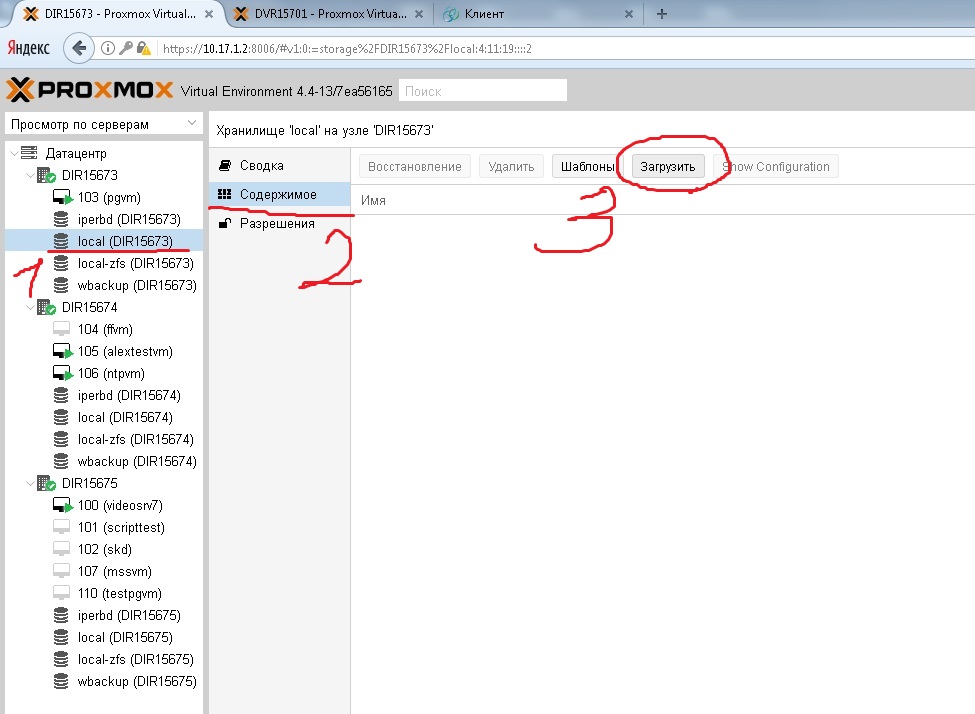

==Создание VM== | ==Создание VM== | ||

| + | Перед созданием VM нужно закачать iso образы (Debian 8.5/8.6) на локальные диски ноды, чтобы потом можно было установить OS на виртуальную машину | ||

| + | |||

| + | [[Файл:cl_23.jpg|центр|]] | ||

| − | + | Выбираем необходимый iso образ, в нашем случае '''debian-8.6.0-amd64-DVD-1''' и нажимаем '''загрузить'''. Дождаться завершения закачки iso образа на Ноду по сети. Таких образов можно хранить любое количество, зависит от потребности и свободного места на локальных OSD. | |

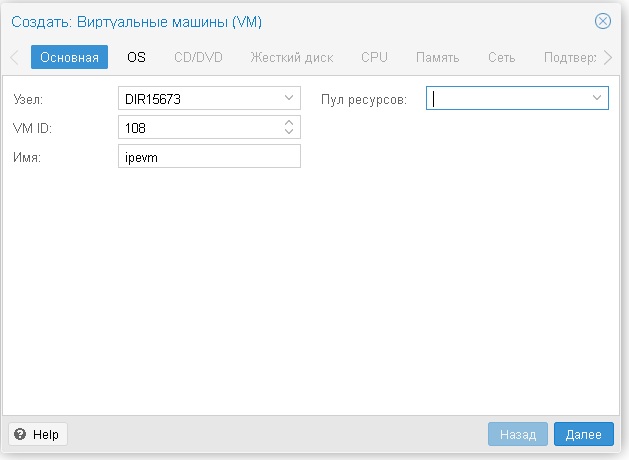

| + | Затем переходим к созданию VM – на веб-интерфейс proxmox выбираем '''«Создать VM»''' в верхнем правом углу, в следующем окне: | ||

| − | + | [[Файл:cl_24.jpg|центр|]] | |

| − | + | ||

| − | + | где '''Узел''' это — имя ноды, '''VM ID''' - это идентификатор виртуальной машины, '''Имя''' — название виртуальной машины. '''У Вас будет всё свое.''' Нажимаем далее | |

| + | |||

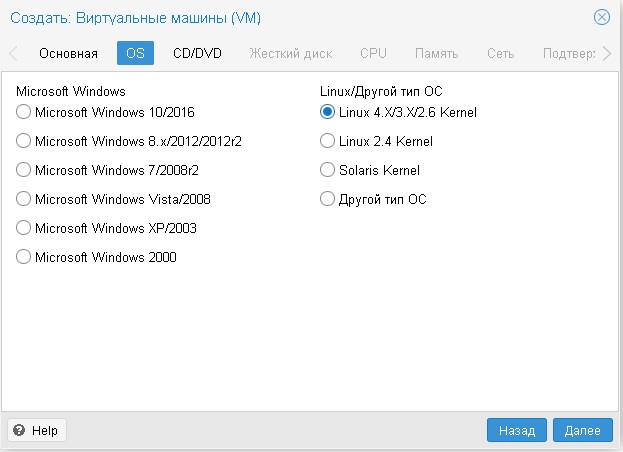

| + | В следующем окне выбираем тип ОС (В нашем случае для Debiana 8.6 – '''ядро Linux 4.X/3.X/2.6 Kernel''' | ||

| + | |||

| + | [[Файл:cl_25.jpg|центр|]] | ||

| + | |||

| + | Нажимаем '''«далее»''' | ||

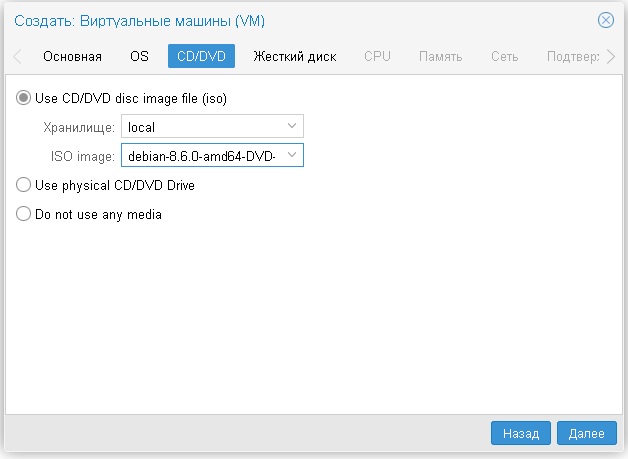

| − | + | [[Файл:cl_26.jpg|центр|]] | |

| − | + | Указываем закаченный нами образ, с которого будет устанавливаться ОС | |

| − | + | [[Файл:cl_27.jpg|центр|]] | |

| − | + | Нажимаем «далее» | |

| − | |||

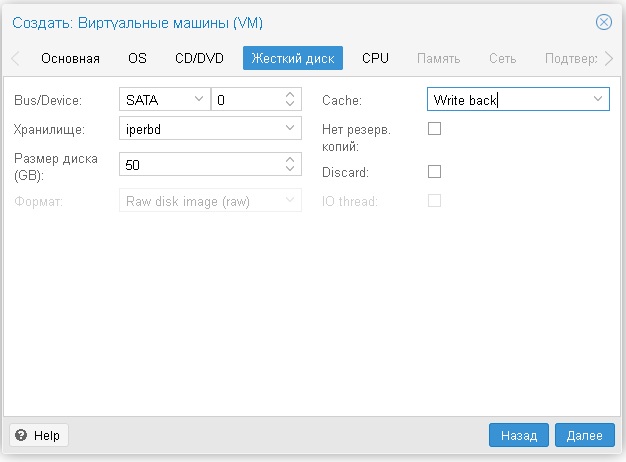

| + | Выбираем SATA, и указываем размер диска для виртуальной машины, Cache обязательно '''Write back''' | ||

| − | + | Нажимаем '''«далее»''' | |

| − | |||

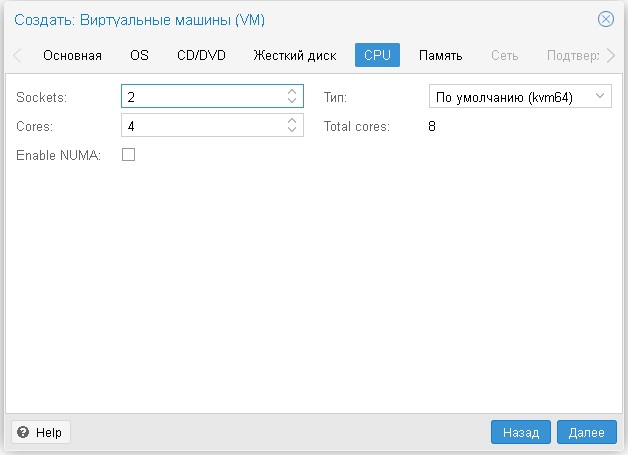

| − | + | Выбираем необходимое количество '''Sockets''' и '''Cores (ядер) процессора''' | |

| − | + | ||

| − | + | [[Файл:cl_28.jpg|центр|]] | |

| + | |||

| + | Нажимаем '''«далее»''' | ||

| + | |||

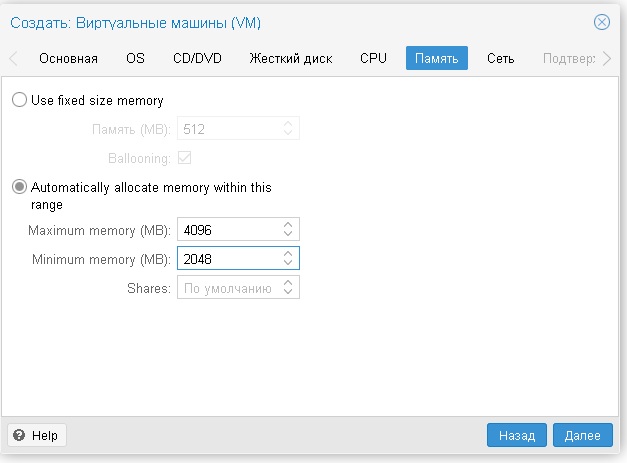

| + | Выбираем авто определение ОЗУ и указываем по необходимости размер (минимум и максимум) | ||

| + | [[Файл:cl_29.jpg|центр|]] | ||

| + | |||

| + | Нажимаем '''«далее»''' | ||

| + | |||

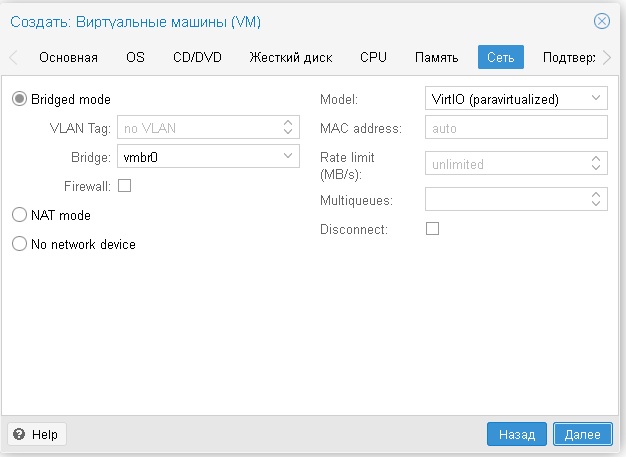

| + | '''Сеть''' оставляем без изменений | ||

| − | + | [[Файл:cl_30.jpg|центр|]] | |

| − | + | Нажимаем '''«далее»''' и в последней закладке нажимаем '''«завершить»''' | |

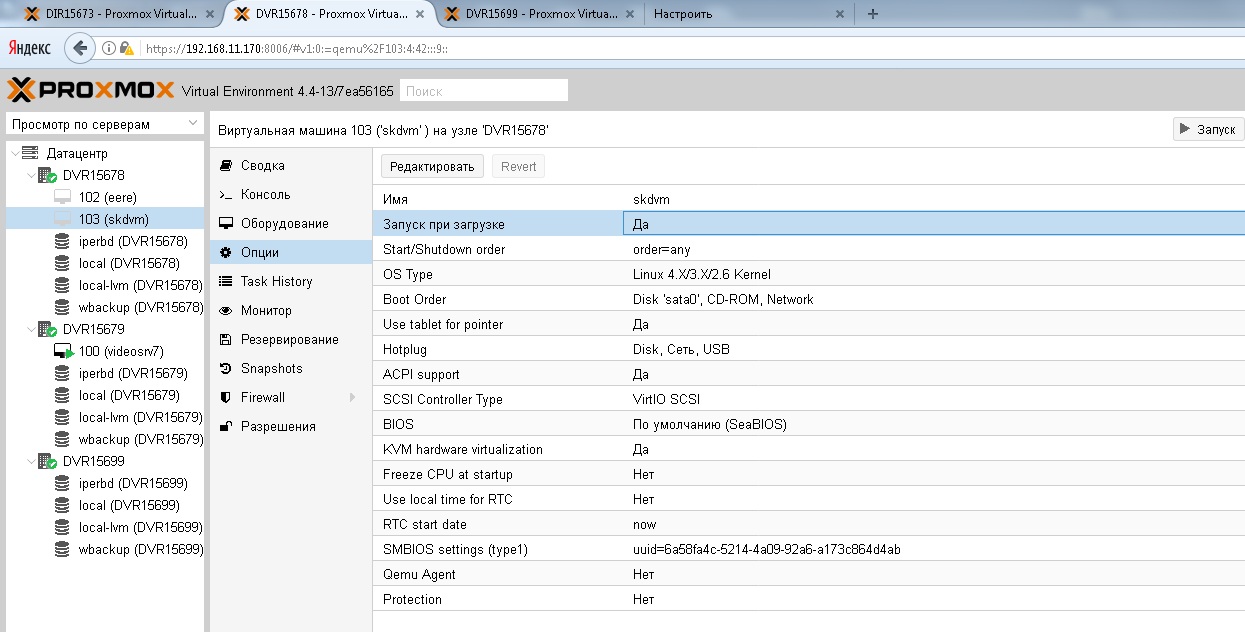

| − | + | Новая VM появится именно на той ноде, которая была указана при создании VM. На каждой ноде может быть несколько VM, все зависит от поставленных задач и мощности серверов (нодов) состоящих в кластере. По умолчанию VM не запущена и не установлена в автозапуск вместе с proxmox. Запустить можно кнопкой «запуск» в верхнем правом углу веб-интерфейса, а загружать автоматически можно изменив параметр '''«Запуск при загрузке»''': | |

| − | |||

| − | + | [[Файл:cl_31.jpg|центр|]] | |

| − | + | ||

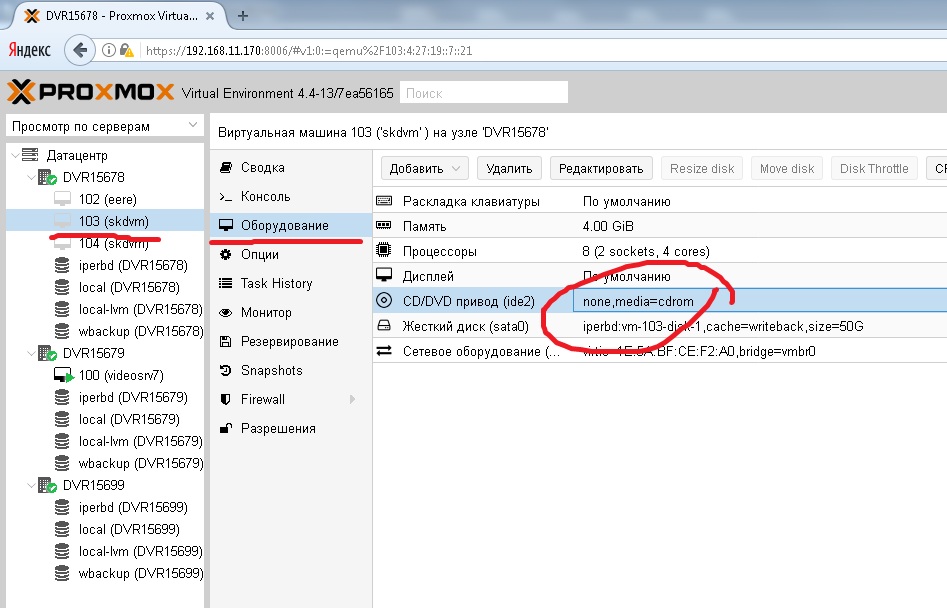

| + | После установки ОС на виртуальную машину, iso образ обязательно нужно размонтировать, иначе система будет загружаться с образа. Должно быть так | ||

| + | [[Файл:cl_32.jpg|центр|]] | ||

| − | + | Если после подключения к VM по двойному клику мыши виден только '''черный экра'''н — нажмите Enter при активном окне VM. | |

===Экспорт/импорт VM=== | ===Экспорт/импорт VM=== | ||

| − | 1 | + | 1. Экпортируем с кластера-донора (Node) открываем консоль |

| − | #rbd export ipepool/vm-106-disk-1 - | pv | dd of=vm-106-disk-1 | + | <nowiki>#rbd export ipepool/vm-106-disk-1 - | pv | dd of=vm-106-disk-1</nowiki> |

либо | либо | ||

| − | #rbd export ipepool/vm-106-disk-1 - | dd of=vm-106-disk-1 | + | <nowiki>#rbd export ipepool/vm-106-disk-1 - | dd of=vm-106-disk-1</nowiki> |

| − | где vm-106-disk-1 — ID VM | + | где '''vm-106-disk-1 — ID VM''' |

затем запаковываем, переходим в папку где лежит файл raw и пишем | затем запаковываем, переходим в папку где лежит файл raw и пишем | ||

| − | #tar -zcvf test.tar.gz vm-106-disk-1 | + | <nowiki>#tar -zcvf test.tar.gz vm-106-disk-1</nowiki> |

| − | где test – имя архива | + | где '''test''' – имя архива |

| − | + | '''vm-106-disk-1''' – это имя архивируемого образа | |

При упаковке и распаковке нельзя закрывать окно | При упаковке и распаковке нельзя закрывать окно | ||

| − | Копируем через WinSCP к себе запакованный образ | + | Копируем через '''WinSCP''' к себе запакованный образ |

| − | 2 | + | 2. Импортируем на кластер-акцептор |

Копируем и распаковываем образ VM командой | Копируем и распаковываем образ VM командой | ||

| − | #tar -zxvf test.tar.gz | + | <nowiki>#tar -zxvf test.tar.gz</nowiki> |

заходим в директорию с образом и пишем | заходим в директорию с образом и пишем | ||

| − | #dd if=vm-106-disk-1 | pv | rbd import --image-format 2 --image-feature layering – ipepool/vm-106-disk-1 | + | <nowiki>#dd if=vm-106-disk-1 | pv | rbd import --image-format 2 --image-feature layering – ipepool/vm-106-disk-1</nowiki> |

либо | либо | ||

| − | #dd if=vm-106-disk-1 | rbd import --image-format 2 --image-feature layering – ipepool/vm-106-disk-1 | + | <nowiki>#dd if=vm-106-disk-1 | rbd import --image-format 2 --image-feature layering – ipepool/vm-106-disk-1</nowiki> |

Заходим в директорию с конфигурационными файлами вм'ов на клаcтере-доноре через WinSCP | Заходим в директорию с конфигурационными файлами вм'ов на клаcтере-доноре через WinSCP | ||

| − | cd /etc/pve/qemu-server | + | <nowiki>cd /etc/pve/qemu-server</nowiki> |

| − | и копируем себе файл ХХХ.conf, а затем подкидываем его на кластера-акцептор по пути | + | и копируем себе файл '''ХХХ.conf''', а затем подкидываем его на кластера-акцептор по пути |

| − | cd /etc/pve/qemu-server; | + | <nowiki>cd /etc/pve/qemu-server;</nowiki> |

машина появиться на веб-интерфейсе кластера-акцептора | машина появиться на веб-интерфейсе кластера-акцептора | ||

| − | 3 | + | 3. Смотрим результат |

| − | #rbd -p ipepool ls | + | <nowiki>#rbd -p ipepool ls</nowiki> |

| − | #rbd info ipepool/vm-106-disk-1 | + | <nowiki>#rbd info ipepool/vm-106-disk-1</nowiki> |

| − | 4 | + | 4. Если требуется удалить VM |

| − | #rbd -p ipepool rm <diskname> | + | <nowiki>#rbd -p ipepool rm <diskname></nowiki> |

| − | (удаление лишних feature) rbd feature disable vm-106-disk-1 <feature> | + | (удаление лишних feature) '''rbd feature disable vm-106-disk-1 <feature>''' |

| − | Обязательно сменить сет. настройки и имена у VM, иначе будет конфликт IP адресов! | + | ''Обязательно сменить сет. настройки и имена у VM, иначе будет конфликт IP адресов!'' |

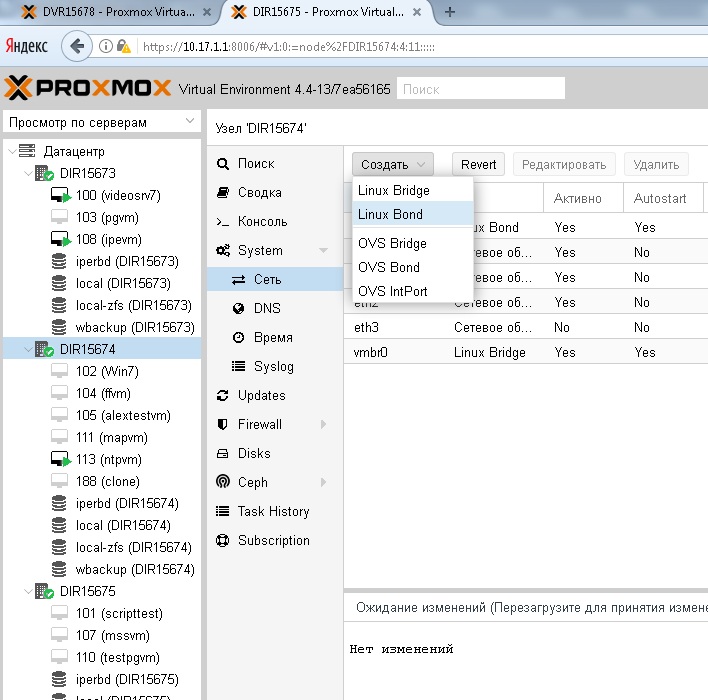

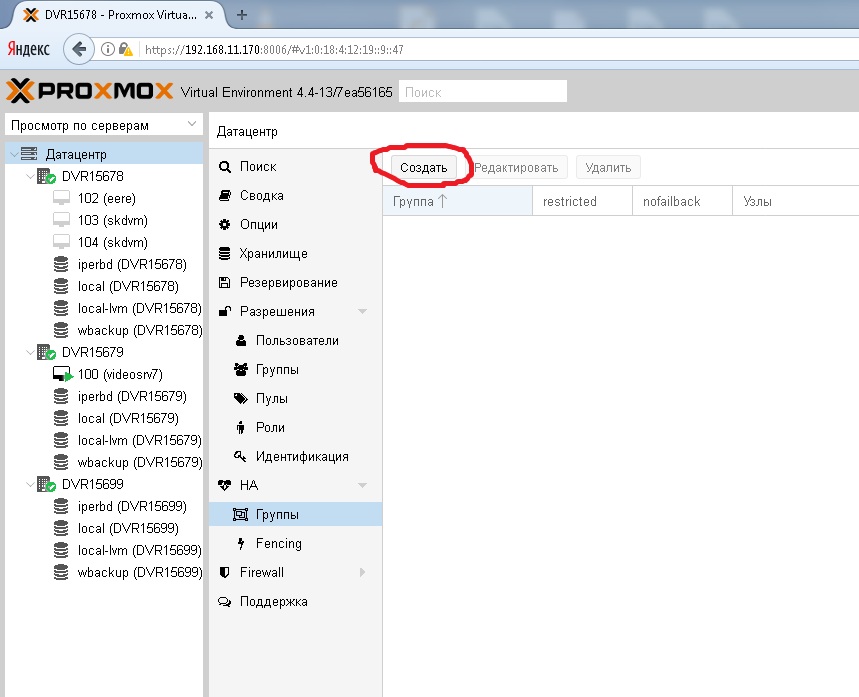

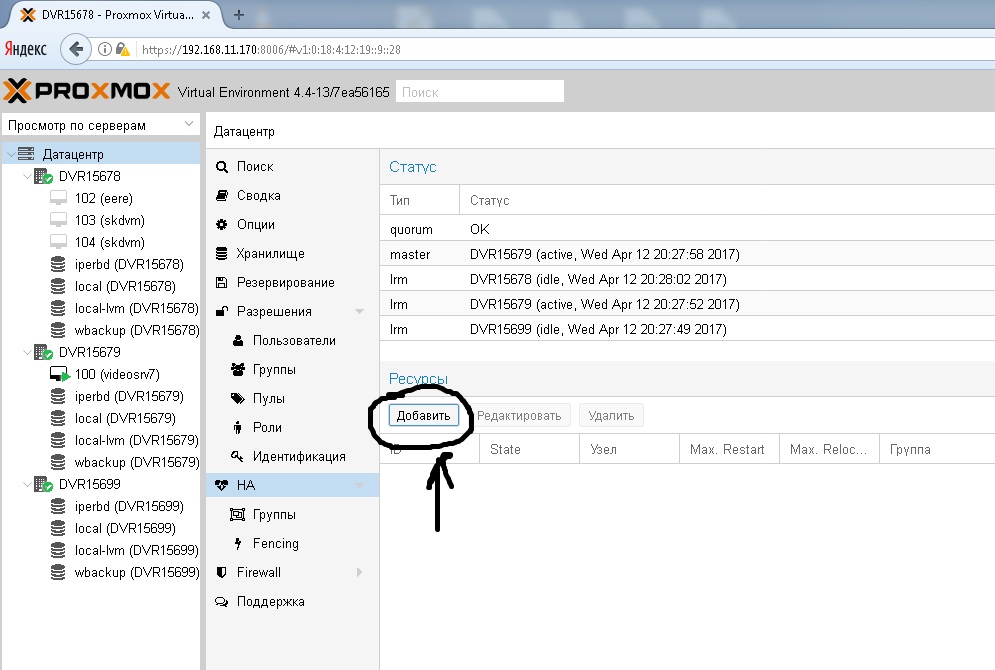

| + | ==HA для мигрирования VM (создание групп)== | ||

| − | + | Для начала необходимо создать группу нодов участвующих в миграции своих VM | |

| − | + | [[Файл:cl_33.jpg|центр|]] | |

| + | [[Файл:cl_34.jpg|центр|]] | ||

| − | + | Далее указываем ID (имя) и выбираем серверы в группу (галочкой) | |

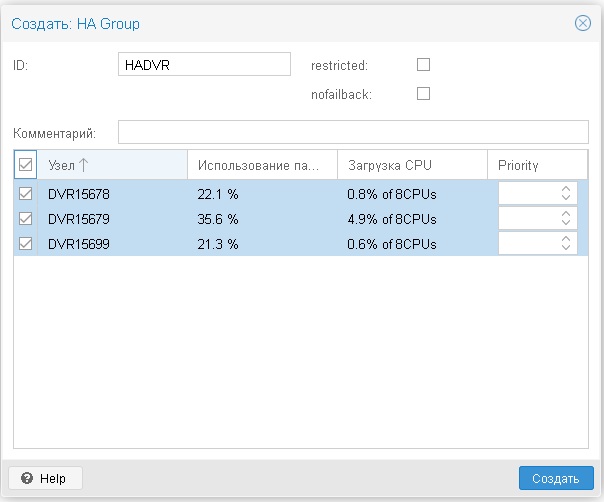

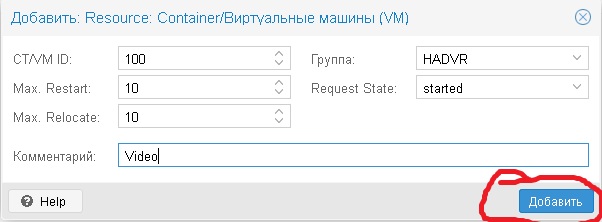

| − | Затем переход на закладку HA и нажимаем «добавить» | + | Затем переход на закладку HA и нажимаем '''«добавить»''' |

| + | [[Файл:cl_35.jpg|центр|]] | ||

| − | + | В открывшимся окне заполняем ID VM которая хотите чтобы мигрировала и указываем число перезапуска (1 по умолчанию), можно вписать комментарий | |

| − | |||

| + | [[Файл:cl_36.jpg|центр|]] | ||

| − | + | '''Проделать со всем ID нодами, которые необходимы для миграции''' | |

| − | + | При миграции VM с одной нод на другую в ручную в режиме «онлайн» могут помешать подключенные устройства USB и прочие. Отключите их и попробуйте заного. | |

| − | + | Например ручное мигрирование VM не доступно для VM на которой установлен Видео-сервер, потому что USB-ключ защиты не позволяет произвести миграцию. | |

| − | |||

| − | |||

| − | |||

| − | |||

| + | Т.к. ключи защиты установлены на всех четерых Нод (включая Zip нод), а рег-файлы всех четырех ключей находятся в папке с установленной video-server 7.0 — при автоматической миграции (если нода выходит из строя) проблем с лицензированием не произойдет. Каждый ключ цепляет свой рег-файл. | ||

| + | Если автоматическое мигрирование VM произошло неудачно (красный крестик на ID VM) попробуйте удалить/изменить ресурсы или группы HA, а затем произвести миграция в ручную на ту ноду, на которой эта VM работала корректно. | ||

==Moxa (настройка)== | ==Moxa (настройка)== | ||

| − | apt install gcc make linux-headers-$(uname -r) | + | apt install gcc make linux-headers-$(uname -r) |

| + | 1) choose kernel 3.x | ||

| + | 2) #скопировать подготовленный moxa драйвер в /root | ||

| + | 3) #cd /root/moxa/kernerl3.x | ||

| + | #./mxinst | ||

| + | y | ||

| + | N | ||

| + | # cd /usr/lib/npreals2/driver/ | ||

| + | # ./mxaddsvr [ip moxa] 2 | ||

| + | 4) #cp /root/moxa/npreals /etc/init.d/ | ||

| + | 5) #update-rc.d npreals remove && update-rc.d npreals defaults | ||

| + | 6) #cp /root/moxa/ntp /etc/init.d/ | ||

| + | 7) #update-rc.d ntp remove && update-rc.d ntp defaults | ||

| − | + | ==Использование скрипта для добавления новых database, mss, ff== | |

| + | на VM-ках | ||

| − | + | 1. Сменить всем вм машинам ip-адреса | |

| − | + | 2. Сменить всем вм машинам IP в hosts | |

| − | + | 3. Запустить скрипты по созданию database, ff, mss на соответствующих вм | |

| − | + | ||

| − | + | :3.1. Запускать скрипт из папки командой | |

| − | # | + | <nowiki># ./<скрипт создающий></nowiki> |

| + | <nowiki># ./<скрипт удаляющий></nowiki> | ||

| + | |||

| + | :3.2. При создании использовать имена без пробелов и спец символов | ||

| − | + | (на pgvm поправить конфиг файл) | |

| − | + | №1 Base | |

| − | + | #ls – что лежит в текущей папке | |

| − | + | видим '''postgresql''' | |

| − | + | переходим в '''#cd postgresql''' | |

| + | '''<nowiki>#ls</nowiki>''' – видим скрипт | ||

| + | Делаем исполняемым, если не было проделано | ||

| − | + | '''<nowiki>#chmod +x <имя скрипта></nowiki>''' | |

| − | |||

| − | + | Запускаем | |

| − | + | '''<nowiki>#./createNewdb.sh</nowiki>''' | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Запустился скрипт-диалог | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

1. server host: 10.17.9.101 (сервер с базами данных) | 1. server host: 10.17.9.101 (сервер с базами данных) | ||

| + | |||

2. server port: 5432 | 2. server port: 5432 | ||

| + | |||

3. user name: postgres | 3. user name: postgres | ||

| + | |||

4. user password: acuario | 4. user password: acuario | ||

| + | |||

5. database name: <имя объекта> (PN1-PN16) (без пробелов и спецсимволов) | 5. database name: <имя объекта> (PN1-PN16) (без пробелов и спецсимволов) | ||

| + | |||

6. database template: template_postgis (оставляем как есть) | 6. database template: template_postgis (оставляем как есть) | ||

| + | |||

идет создание базы, ничего не трогаем до завершения | идет создание базы, ничего не трогаем до завершения | ||

| + | |||

№2 FF | №2 FF | ||

| − | #ls – что лежит в текущей папке, видим firefly | + | |

| − | #cd firefly | + | '''<nowiki>#ls</nowiki>''' – что лежит в текущей папке, видим firefly |

| − | #ls – аналогично | + | |

| − | Делаем исполняемым — аналогично, scriptffcreate.sh | + | '''<nowiki>#cd</nowiki> firefly''' |

| + | |||

| + | '''<nowiki>#ls</nowiki>''' – аналогично | ||

| + | |||

| + | Делаем исполняемым — аналогично, '''scriptffcreate.sh''' | ||

| + | |||

Запускаем | Запускаем | ||

| − | #./scriptffcreate.sh | + | |

| + | '''<nowiki>#./scriptffcreate.sh</nowiki>''' | ||

| + | |||

| + | |||

Запустился скрипт-диалог | Запустился скрипт-диалог | ||

| + | |||

1. firefly name: firefly (по умолчанию) меняем на fireflyPN1-PN16 | 1. firefly name: firefly (по умолчанию) меняем на fireflyPN1-PN16 | ||

| + | |||

2. firefly path: /opt | 2. firefly path: /opt | ||

| + | |||

3. firefly wamp port: 8090 (по умолчанию) меняем на нужный 8091-8106 | 3. firefly wamp port: 8090 (по умолчанию) меняем на нужный 8091-8106 | ||

| + | |||

4. firefly http port: 10000 (по умолчанию) меняем на 10001-10016 | 4. firefly http port: 10000 (по умолчанию) меняем на 10001-10016 | ||

| + | |||

5. serenity ip 10.17.1.1 меняем на нужный | 5. serenity ip 10.17.1.1 меняем на нужный | ||

| + | |||

6. serenity port:8888, меняем на нужный | 6. serenity port:8888, меняем на нужный | ||

| + | |||

7. acuario2 dbname:PN1, меняем на нужное имя базы PN1-PN16 | 7. acuario2 dbname:PN1, меняем на нужное имя базы PN1-PN16 | ||

| + | |||

8. postgresql ip: 10.17.1.1 меняем на наш сервер базы данных 10.17.9.101 | 8. postgresql ip: 10.17.1.1 меняем на наш сервер базы данных 10.17.9.101 | ||

| + | |||

запускается FF как демон | запускается FF как демон | ||

| − | Проверка, что он | + | |

| − | #systemctl status fireflyPN2 – видим статус active (running) зеленым цветом, значит все ок. | + | Проверка, что он запусти'''лся |

| + | |||

| + | <nowiki>#systemctl</nowiki> status fireflyPN2 – видим статус active (running) зеленым цветом, значит все ок. | ||

| + | |||

| + | |||

| + | |||

№3 MSS | №3 MSS | ||

| − | #ls – что лежит в текущей папке, увидим mss | + | '''<nowiki>#ls</nowiki>''' – что лежит в текущей папке, увидим mss |

| − | #cd mss | + | |

| − | #ls видим скрипт scriptmsscreate.sh | + | '''<nowiki>#cd mss</nowiki>''' |

| − | делаем исполняемым если не проделано ранее | + | |

| − | #chmod +x <имя скрипта> | + | '''#ls''' видим скрипт scriptmsscreate.sh |

| − | Запускаем #./scriptmsscreate.sh | + | |

| + | делаем исполняемым если не проделано ранее | ||

| + | |||

| + | '''<nowiki>#chmod</nowiki> +x <имя скрипта>''' | ||

| + | |||

| + | Запускаем '''<nowiki>#./scriptmsscreate.sh</nowiki>''' | ||

| + | |||

| + | |||

Диалог | Диалог | ||

1. mss name: mss (по умолчанию), меняем на нужное например mssPN2 | 1. mss name: mss (по умолчанию), меняем на нужное например mssPN2 | ||

| + | |||

2. ff ip: 10.17.1.1 — меняем на наш (10.17.9.103) | 2. ff ip: 10.17.1.1 — меняем на наш (10.17.9.103) | ||

| + | |||

3 ff port: 8080 по умолч., меняем на 8091-8106 | 3 ff port: 8080 по умолч., меняем на 8091-8106 | ||

| + | |||

4. serenity ip: 10.17.1.1, меняем на нужный | 4. serenity ip: 10.17.1.1, меняем на нужный | ||

| + | |||

5. serenity port: 8888 | 5. serenity port: 8888 | ||

| + | |||

6. mss path: /opt | 6. mss path: /opt | ||

| Строка 795: | Строка 878: | ||

Проверяем его статус, аналогично ff | Проверяем его статус, аналогично ff | ||

| − | #systemctl status mssPN2 | + | <nowiki>#systemctl status mssPN2</nowiki> |

ожидаем состояния active (running) зеленым цветом | ожидаем состояния active (running) зеленым цветом | ||

| − | |||

==Использование Zip сервера (четвёртого Нод)== | ==Использование Zip сервера (четвёртого Нод)== | ||

| Строка 804: | Строка 886: | ||

Замена вышедшего из строя сервера (node) | Замена вышедшего из строя сервера (node) | ||

| − | 1 | + | 1. добавить новую ноду и удалить неработающую ноду из кластера |

| − | 2 | + | |

| − | 3 | + | 2. добавить новый монитор и удалить неработающий |

| + | |||

| + | 3. добавить новый gluster brick и удалить неработающий | ||

| + | |||

| + | :1.1. на второстепенной ноде | ||

| + | |||

| + | :ipenode2:~#pvecm add ipenode1 | ||

| + | |||

| + | :1.2. проверяем статус | ||

| + | |||

| + | :ipenode2:~#pvecm status | ||

| + | |||

| + | :1.3. удаляем неработающую ноду | ||

| + | |||

| + | :ipenode2:~#pvecm delnode <имя сгоревшей машины> | ||

| + | |||

| + | |||

| + | :2.1. добавляем монитор как обычно + прописываем ip нового монитора в файл (строка mohost) | ||

| + | |||

| + | :<nowiki>#nano /etc/pve/storage.cfg</nowiki> | ||

| + | |||

| + | :2.2) посмотри внимательней storage.cfg | ||

| + | |||

| + | :nano /etc/pve/storage.cfg | ||

| + | |||

| + | :nano /etc/pve/ceph.conf | ||

| + | |||

| + | :<nowiki>### move/remove mon ###</nowiki> | ||

| + | |||

| + | :ceph mon getmap -o /tmp/monmap | ||

| + | |||

| + | :monmaptool --print /tmp/monmap | ||

| + | |||

| + | :monmaptool --rm {id} /tmp/monmap | ||

| + | |||

| + | :<nowiki>#stop all your monitors! Не нужно, достаточно 1</nowiki> | ||

| + | |||

| + | :ceph-mon -i {working mon-id} --inject-monmap /tmp/monmap | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

делаем изменение в одном мониторе, остальные подхватят и обновят инфу по рабочим мониторам | делаем изменение в одном мониторе, остальные подхватят и обновят инфу по рабочим мониторам | ||

| − | 3 | + | |

| − | #gluster volume add-brick <wbackup> replica 4 <newnode>:/media/gfs/wbackup force | + | 3. добавляем новый gluster brick |

| + | |||

| + | <nowiki>#gluster volume add-brick <wbackup> replica 4 <newnode>:/media/gfs/wbackup force</nowiki> | ||

| + | |||

удаляем сгоревший | удаляем сгоревший | ||

| − | #gluster volume delete-brick <wbackup> replica 3 <oldnode>:/media/gfs/wbackup force | + | |

| + | <nowiki>#gluster volume delete-brick <wbackup> replica 3 <oldnode>:/media/gfs/wbackup force</nowiki> | ||

| + | |||

nano /etc/pve/storage.cfg | nano /etc/pve/storage.cfg | ||

| + | |||

Datacenter → storage → wbackup [edit] (add new node) | Datacenter → storage → wbackup [edit] (add new node) | ||

| − | 4 | + | |

| + | 4. удаление osd мертвой машины | ||

| + | |||

ID={osd-num} | ID={osd-num} | ||

| + | |||

pveceph stop osd.$ID | pveceph stop osd.$ID | ||

| + | |||

ceph osd out osd.$ID | ceph osd out osd.$ID | ||

| + | |||

pveceph destroyosd $ID | pveceph destroyosd $ID | ||

| − | # ceph osd getcrushmap -o crushmapdump | + | |

| − | # crushtool -d crushmapdump -o crushmapdump-decompiled | + | <nowiki># ceph osd getcrushmap -o crushmapdump</nowiki> |

| − | # nano crushmapdump-decompiled | + | |

| − | + | <nowiki># crushtool -d crushmapdump -o crushmapdump-decompiled</nowiki> | |

| − | # crushtool -c crushmapdump-decompiled -o crushmapdump-compiled | + | |

| − | # ceph osd setcrushmap -i crushmapdump-compiled | + | <nowiki># nano crushmapdump-decompiled</nowiki> |

| + | |||

| + | :удалить все упоминания сгоревшей машины и osd | ||

| + | |||

| + | <nowiki># crushtool -c crushmapdump-decompiled -o crushmapdump-compiled</nowiki> | ||

| + | |||

| + | <nowiki># ceph osd setcrushmap -i crushmapdump-compiled</nowiki> | ||

| + | |||

получить ответ | получить ответ | ||

| + | |||

set crush map --> all ok | set crush map --> all ok | ||

==Ntp server, синхронизация времени, GPS Датчик (настройка)== | ==Ntp server, синхронизация времени, GPS Датчик (настройка)== | ||

| − | 1 | + | 1. Сменить всем вм машинам ip-адреса |

| + | |||

| + | 2. Сменить всем вм машинам имена | ||

| + | |||

| + | 3. Настройка ntpvm: после прохождения 1 и 2 пункта, далее добавить сервер (moxa) | ||

| − | 2 | + | <nowiki># /usr/lib/npreals2/driver/mxaddsvr <ip moxa> 2</nowiki> |

| − | + | :3.1. Если все сделано верно, будет создано несколько устройств COM порта; | |

| − | + | :с помощью команды | |

| − | + | :<nowiki># cat /dev/ttyrX</nowiki> | |

| − | + | :X-порядковый номер (1,2,3 и т.д.) | |

| − | + | :должны пойти данные формата NMEA 0183 | |

| − | |||

| − | |||

| − | + | :3.2. Поправить скрипт, если файл-устройство отличается от написанного в скрипте | |

| − | + | :/root/moxa/npreals.sh | |

| − | + | :На всех нодах должен быть установлен ntp, если не установлен устанавливаем его (через интернет или локальных репозиториев) | |

| − | #apt install ntp | + | <nowiki>#apt install ntp</nowiki> |

Затем на каждой Ноде нужно поменять значения в файле | Затем на каждой Ноде нужно поменять значения в файле | ||

| − | #nano /etc/ntp.conf | + | <nowiki>#nano /etc/ntp.conf</nowiki> |

меняем на наш IP у ntpVM | меняем на наш IP у ntpVM | ||

| Строка 882: | Строка 1005: | ||

VM через веб интерфейс | VM через веб интерфейс | ||

| − | #ntpd — gq | + | <nowiki>#ntpd — gq</nowiki> |

Командой #data можно проверить текущее время | Командой #data можно проверить текущее время | ||

| Строка 888: | Строка 1011: | ||

При удачной сихронизации времени на Нодах, значок будет таким | При удачной сихронизации времени на Нодах, значок будет таким | ||

| + | [[Файл:cl_37.jpg|центр|]] | ||

| + | ===GPS/Glonass=== | ||

| − | + | 1. Подсоединить R+/D+ (A); R-/D- (B), где А-зеленый, В- белый | |

| + | |||

| + | 2. Настроить Моху (вебморда) | ||

| − | |||

| − | |||

Port 2: | Port 2: | ||

| − | + | ||

| − | + | :Interface [RS-485 2WIRE] | |

| − | 3 | + | |

| + | :Baud rate [115200] | ||

| + | |||

| + | 3. Виртуальные com ports: | ||

| + | |||

RS-485 = /dev/ttyr(number) | RS-485 = /dev/ttyr(number) | ||

| + | |||

RS-232 = /dev/ttyr0(number) | RS-232 = /dev/ttyr0(number) | ||

| − | 4 | + | |

| + | 4. Настройка скорости и т.п.: | ||

| + | |||

chmod . . . | chmod . . . | ||

| + | |||

ln -s /dev/ttyr3 /dev/gps0 -для драйвера NMEA на 127.127.20.0 (0 — порядковый номер gps устройства) | ln -s /dev/ttyr3 /dev/gps0 -для драйвера NMEA на 127.127.20.0 (0 — порядковый номер gps устройства) | ||

| + | |||

chmod 777 /dev/ttyr* | chmod 777 /dev/ttyr* | ||

| + | |||

stty -F /dev/gps0 115200 (устанавливаем скорость) | stty -F /dev/gps0 115200 (устанавливаем скорость) | ||

| + | |||

для проверки скорости: | для проверки скорости: | ||

| + | |||

stty -F /dev/gps0 | stty -F /dev/gps0 | ||

| − | + | ||

| + | 5. При правильном подключении проверим выходные данные: | ||

| + | |||

cat /dev/gps0 | cat /dev/gps0 | ||

| + | |||

при неверно выставленной скорости пойдут иероглифы | при неверно выставленной скорости пойдут иероглифы | ||

| + | |||

при верной конфигурации - координаты формата NMEA 0183 | при верной конфигурации - координаты формата NMEA 0183 | ||

| − | + | ||

| − | + | 6. apt install ntp | |

| − | # Local Clock — если теряем спутники, то снижаем stratum до 10 | + | |

| − | #server 127.127.1.0 | + | 7. правим конфиг: |

| − | #fudge 127.127.1.0 stratum 10 | + | |

| − | # NMEA GPS driver | + | # Local Clock — если теряем спутники, то снижаем stratum до 10 |

| − | server 127.127.20.0 prefer mode 80 #mode 80 означает скорость 115200bps | + | #server 127.127.1.0 |

| − | driftfile /var/lib/ntp/ntp.drift | + | #fudge 127.127.1.0 stratum 10 |

| − | restrict default nomodify notrust # Отдаём время всем | + | # NMEA GPS driver |

| − | restrict 127.0.0.1 # Разрешаем себе всё | + | server 127.127.20.0 prefer mode 80 #mode 80 означает скорость 115200bps |

| − | disable auth | + | driftfile /var/lib/ntp/ntp.drift |

| − | #logfile /var/log/ntp/messages | + | restrict default nomodify notrust # Отдаём время всем |

| − | + | restrict 127.0.0.1 # Разрешаем себе всё | |

| + | disable auth | ||

| + | #logfile /var/log/ntp/messages | ||

| + | 8. рестарт службы для принzтия настроек: | ||

| + | |||

systemctl restart ntp | systemctl restart ntp | ||

| + | |||

systemctl status ntp | systemctl status ntp | ||

| + | |||

не должно быть ошибок, active(running) | не должно быть ошибок, active(running) | ||

| + | |||

проверить на наличие строки в статусе: GPS_NMEA(0) serial /dev/gps0 open at 115200 bps | проверить на наличие строки в статусе: GPS_NMEA(0) serial /dev/gps0 open at 115200 bps | ||

| − | 8 | + | |

| + | 8. ntpq -p | ||

| + | |||

должна быть строка | должна быть строка | ||

| + | |||

*GPS_NMEA(0) .GPS. 0 l 13 64 77 0.000 0.617 0.792 | *GPS_NMEA(0) .GPS. 0 l 13 64 77 0.000 0.617 0.792 | ||

| + | |||

с * в самом начале, значит - РАБОТАЕТ! | с * в самом начале, значит - РАБОТАЕТ! | ||

| − | + | ||

| + | 9. обновить время: | ||

systemctl stop ntp | systemctl stop ntp | ||

| + | |||

ntpd -gq (можно не стопать службу перед выполнением) | ntpd -gq (можно не стопать службу перед выполнением) | ||

| + | |||

systemctl start ntp | systemctl start ntp | ||

| − | + | ||

| + | 10. Если вы используете udev, то полезно будет создать правило /etc/udev/rules.d/10-gps.rules следующего содержания: | ||

| + | |||

KERNEL==«ttyr3», NAME="%k", SYMLINK+=«gps0», MODE=«0660», GROUP=«uucp» | KERNEL==«ttyr3», NAME="%k", SYMLINK+=«gps0», MODE=«0660», GROUP=«uucp» | ||

| + | |||

==Сервер Авторизации== | ==Сервер Авторизации== | ||

| − | + | == Устранение неисправностей== | |

| − | ==Добавление диска в RAID1 (не работает с HDD Toshiba)== | + | ===Добавление диска в RAID1 (не работает с HDD Toshiba)=== |

Диагностирование потери одного из дисков в RAID1, можно проверить командой | Диагностирование потери одного из дисков в RAID1, можно проверить командой | ||

| − | zpool status | + | '''zpool status |

| − | + | ''' | |

| − | + | Если «развалился» RAID1 на одной из Нод, на которой установлен proxmox, необходима ручная замена HDD. После установки жесткого диска фирмы HGST в первый или второй слот корзинки, необходимо проделать от root следующее | |

| − | fdisk -l /dev/sd* (узнать какие диски видит система) | + | '''fdisk -l /dev/sd*''' (узнать какие диски видит система) |

| − | sgdisk -R /dev/sdb /dev/sda (копирование таблицы разделов) | + | '''sgdisk -R /dev/sdb /dev/sda''' (копирование таблицы разделов) |

| − | sgdisk -G /dev/sdb (форматирование в GPT) | + | '''sgdisk -G /dev/sdb''' (форматирование в GPT) |

| − | grub-install --recheck /dev/sdb (установка загрузчика) | + | '''grub-install --recheck /dev/sdb''' (установка загрузчика) |

| − | update-grub (обновление загрузчика) | + | '''update-grub''' (обновление загрузчика) |

| − | update-initramfs -u | + | '''update-initramfs -u''' |

| − | zpool replace rpool /dev/sdb2 (копирование данных в раздел sdb2) | + | '''zpool replace rpool /dev/sdb2''' (копирование данных в раздел sdb2) |

==Приложения== | ==Приложения== | ||

| − | Список необходимого софта и оборудования | + | ===Список необходимого софта и оборудования=== |

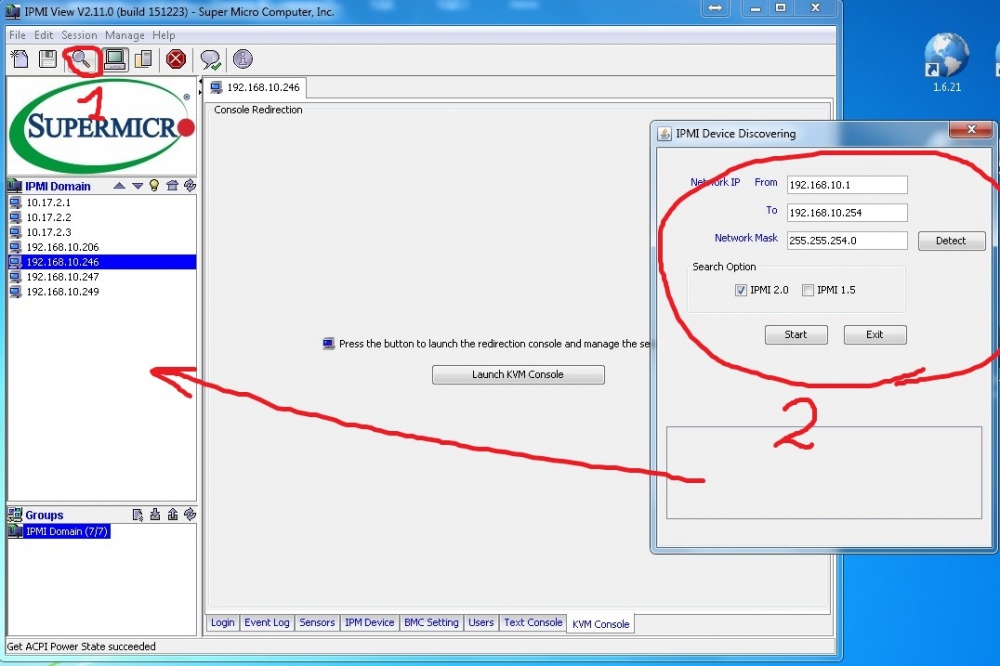

1. Ноутбук с ОС Windows 7 х64, для последующего подключения к общей локальной сети, для удаленной установки proxmox через IPMI (необходимо добавление дополнительного IP в сетевой адаптер на ноутбуке). Так же пригодится для настройки компонентов Планеты и передачи файлов на серверы через WinSCP; | 1. Ноутбук с ОС Windows 7 х64, для последующего подключения к общей локальной сети, для удаленной установки proxmox через IPMI (необходимо добавление дополнительного IP в сетевой адаптер на ноутбуке). Так же пригодится для настройки компонентов Планеты и передачи файлов на серверы через WinSCP; | ||

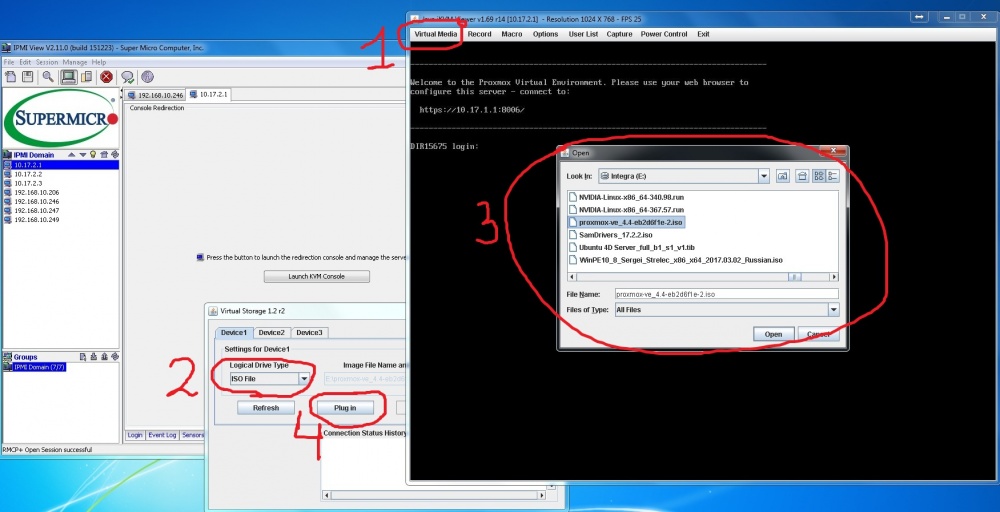

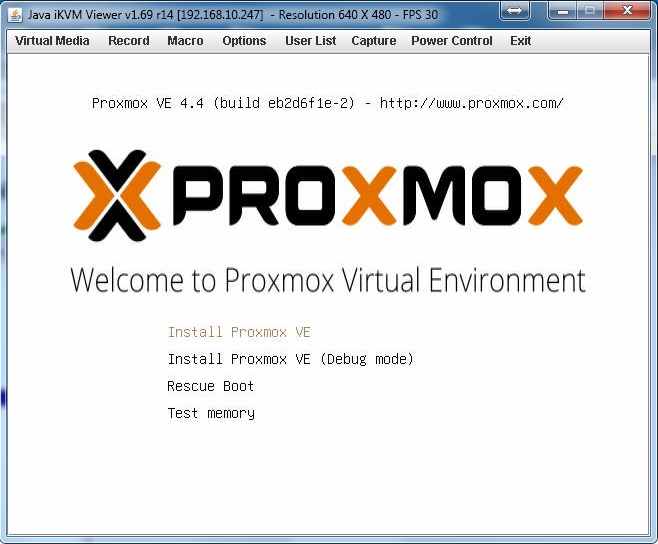

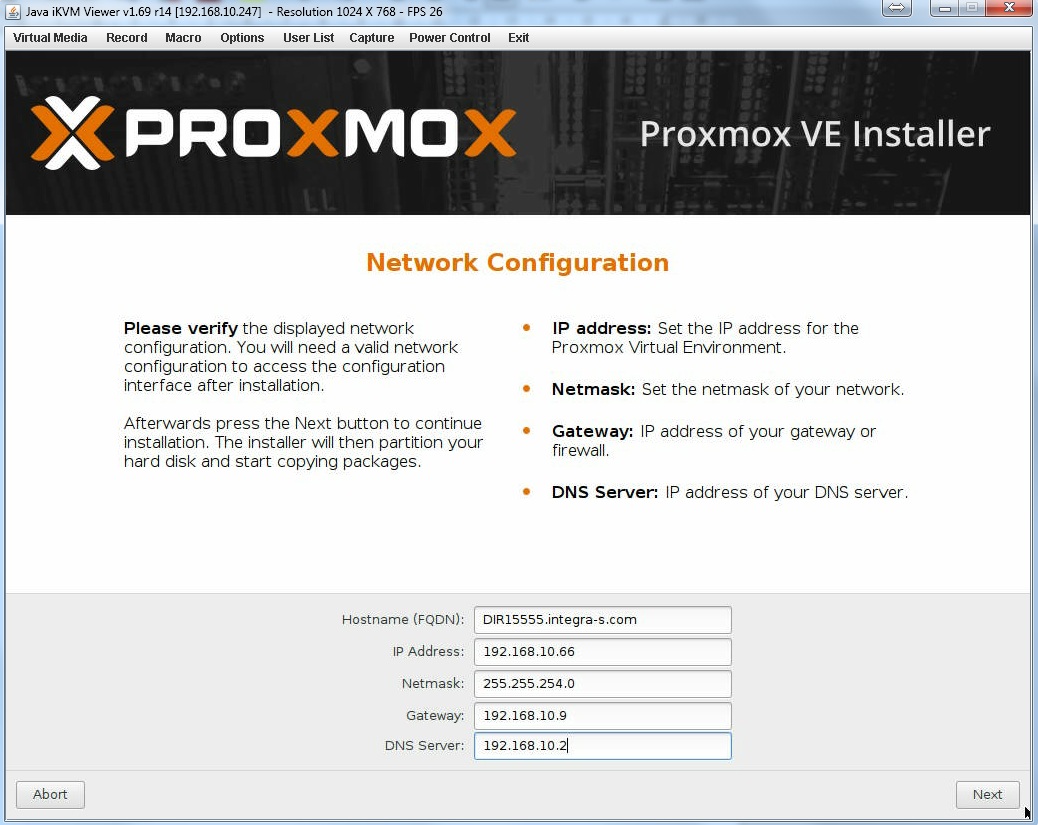

| − | 2. Образ proxmox-ve_4.4-eb2d6f1e-2; | + | 2. Образ '''proxmox-ve_4.4-eb2d6f1e-2;''' |

4. USB ключи защиты + reg-файлы с открытыми паролями от 1 до 1600; | 4. USB ключи защиты + reg-файлы с открытыми паролями от 1 до 1600; | ||

| Строка 977: | Строка 1135: | ||

VM1 <baseVM> | VM1 <baseVM> | ||

| + | |||

VM2 <mmsVM> | VM2 <mmsVM> | ||

| + | |||

VM3 <ffVM> | VM3 <ffVM> | ||

| + | |||

VM4 <skdVM> | VM4 <skdVM> | ||

| + | |||

VM5 <ntpVM> | VM5 <ntpVM> | ||

| + | |||

VM6 <videoVM> | VM6 <videoVM> | ||

| + | |||

VM7 <serenetyVM> | VM7 <serenetyVM> | ||

| + | |||

VM8 <eilyVM> | VM8 <eilyVM> | ||

| + | |||

VM9 <osmVM> | VM9 <osmVM> | ||

4. Образ Live (например WinPE10_8_Sergei_Strelec_x86_x64_2017.03.02_Russian) для чистки HDD и диагностики железа; | 4. Образ Live (например WinPE10_8_Sergei_Strelec_x86_x64_2017.03.02_Russian) для чистки HDD и диагностики железа; | ||

| − | 5. IPMI Supermicro utilities для управления по IPMI (работает только с Windows); | + | 5. '''IPMI Supermicro utilities''' для управления по IPMI (работает только с Windows); |

| − | 6. Подключенный прямой интернет или Локальные репозитории (repo) для обновления Proxmox, а так же для установки необходимых в работе компонентов; | + | 6. Подключенный прямой интернет или '''Локальные репозитории (repo)''' для обновления Proxmox, а так же для установки необходимых в работе компонентов; |

| − | 7. Все необходимые образы (Debian 8.5/8.6, отдельно программы для серверной части Планеты, WinSCP, oracle-xe_11.2.0-2_amd64.deb, oracle-client, СКД клиент, IntegraVideo7.0.776, скрипты для установки mms, ff, database на VM-ках; драйвер для Moxa под Debian, VLC media player, PGAdmin1.2) | + | 7. Все необходимые образы (Debian 8.5/8.6, отдельно программы для серверной части Планеты, WinSCP, oracle-xe_11.2.0-2_amd64.deb, oracle-client, СКД клиент, IntegraVideo7.0.776, скрипты для установки '''mms, ff, database''' на VM-ках; драйвер для Moxa под Debian, VLC media player, PGAdmin1.2) |

===План работы с кластером=== | ===План работы с кластером=== | ||

| − | 1 | + | 1. Настройка BIOS на каждой ноде |

| − | 2 | + | 2. Настройка IPMI на каждой ноде |

| − | 3 | + | 3. Proxmox.iso install |

| − | 4 | + | 4. Закинуть local repo и прописать в repo.list пути к ним + поправить '''/usr/share/perl5/PVE/CLI/pveceph.pm''' |

| − | /usr/share/perl5/PVE/CLI/pveceph.pm | ||

| − | 5 | + | 5. Обновить систему и поставить CEPH |

| − | 6 | + | 6. Поставить пакеты mc htop glusterfs-server pv attr ntp |

| − | 7 | + | 7. Объединить ноды в proxmox cluster |

| − | 8 | + | 8. Настроить glusterfs |

| − | 9 | + | 9. Настроить CEPH |

| − | 10 | + | 10. Закинуть VM’s + изменить все IP адреса и hostname |

| − | + | VM1 <baseVM> | |

| − | + | VM2 <mmsVM> | |

| − | + | VM3 <ffVM> | |

| − | + | VM4 <skdVM> | |

| − | + | VM5 <ntpVM> | |

| − | + | VM6 <videoVM> | |

| − | + | VM7 <serenetyVM> | |

| − | + | VM8 <eilyVM> | |

| − | + | VM9 <osmVM> | |

| − | + | 11. Настроить wbackup | |

| − | 12 | + | 12. Настроить ntpVM + прописать на всех nodes '''/etc/ntp.conf''' нужный конфиг |

===Команды для работы в Linux с IPE=== | ===Команды для работы в Linux с IPE=== | ||

| − | #systemctl status firefly_tracker | + | '''<nowiki>#systemctl status firefly_tracker</nowiki>''' статус работы FF |

| − | |||

| − | |||

| − | |||

| − | |||

| − | #cd /opt/firefly_tracker переход в папку с трекингом | + | '''<nowiki>#systemctl status firefly_integration</nowiki>''' статус работы FF трекинга |

| − | #python firefly.py | + | |

| + | '''<nowiki>#systemctl stop firefly_tracker </nowiki>''' остановка процесса FF | ||

| + | |||

| + | '''<nowiki>#systemctl start firefly_tracker</nowiki>''' запуск процесса FF | ||

| + | |||

| + | '''<nowiki>#systemctl restart firefly_tracker</nowiki>''' перезапуск FF | ||

| + | |||

| + | |||

| + | '''<nowiki>#cd /opt/firefly_tracker</nowiki>''' переход в папку с трекингом | ||

| + | |||

| + | '''<nowiki>#python firefly.py</nowiki> ''' запуск FF | ||

| − | #cd /opt/firefly_integration | + | '''<nowiki>#cd /opt/firefly_integration</nowiki> ''' переход в папку FF |

| − | #cd python firefly.py запуск | + | |

| + | '''<nowiki>#cd python firefly.py </nowiki>''' запуск FF | ||

| + | |||

| + | '''<nowiki>journalctl –no-pager -o cat -u firefly_tracker -1</nowiki>''' просмотр статистики FF трекинга | ||

| + | |||

| + | '''<nowiki>#systemctl status mss </nowiki>''' статус работы mss | ||

| + | |||

| + | '''<nowiki>#systemctl stop mss </nowiki>''' остановка процесса mss | ||

| + | |||

| + | '''<nowiki>#systemctl start mss </nowiki>''' запуск процесса mss | ||

| + | |||

| + | '''<nowiki>#systemctl restart mss </nowiki>''' перезапуск mss | ||

| − | + | '''<nowiki>#cd /opt/mss_tracker </nowiki>''' переход в папку с аcuariomanager | |

| − | # | + | '''<nowiki>#mono am.console.exe</nowiki>''' запуск mms в консольном режиме |

| − | |||

| − | |||

| − | |||

| − | + | '''<nowiki>#mono am.gui.exe </nowiki>''' запуск mms с графикой | |

| − | #mono am. | ||

| − | |||

| − | #systemctl status proftpd статус работы ftp сервера | + | '''<nowiki>#systemctl status proftpd</nowiki>''' статус работы ftp сервера |

| − | |||

| − | |||

| − | |||

| + | '''<nowiki>#systemctl stop proftpd </nowiki>''' остановка процесса ftp | ||

| + | |||

| + | '''<nowiki>#systemctl start proftpd</nowiki>''' запуск процесса ftp | ||

| + | |||

| + | '''<nowiki>#systemctl restart proftpd</nowiki> ''' перезапуск ftp | ||

Для смены пароля от root (зная изначальный пароль) | Для смены пароля от root (зная изначальный пароль) | ||

| − | #passwd | + | '''<nowiki>#passwd</nowiki>''' |

Задать новый пароль, подтвердить | Задать новый пароль, подтвердить | ||

| + | |||

Установка SSH в Debian 8.5/8.6 и доступ c другой машины под root | Установка SSH в Debian 8.5/8.6 и доступ c другой машины под root | ||

| + | |||

Обновляем репозитории | Обновляем репозитории | ||

| + | |||

Первым делом проверим список (/etc/apt/sources.list) доступных репозиториев. Для этого откроем файл /etc/apt/sources.list в редакторе nano и при необходимости добавим ссылки на официальные репозитории.+ | Первым делом проверим список (/etc/apt/sources.list) доступных репозиториев. Для этого откроем файл /etc/apt/sources.list в редакторе nano и при необходимости добавим ссылки на официальные репозитории.+ | ||

| + | |||

nano /etc/apt/sources.list | nano /etc/apt/sources.list | ||

| + | |||

При необходимости добавляем официальные репозитории: | При необходимости добавляем официальные репозитории: | ||

| − | deb http://httpredir.debian.org/debian jessie main | + | |

| − | deb-src http://httpredir.debian.org/debian jessie main | + | deb http://httpredir.debian.org/debian jessie main |

| − | deb http://httpredir.debian.org/debian jessie-updates main | + | deb-src http://httpredir.debian.org/debian jessie main |

| − | deb-src http://httpredir.debian.org/debian jessie-updates main | + | deb http://httpredir.debian.org/debian jessie-updates main |

| − | deb http://security.debian.org/ jessie/updates main | + | deb-src http://httpredir.debian.org/debian jessie-updates main |

| − | deb-src http://security.debian.org/ jessie/updates main | + | deb http://security.debian.org/ jessie/updates main |

| + | deb-src http://security.debian.org/ jessie/updates main | ||

| + | |||

Если вы обновили список репозиториев, то сохраняйте изменения в файле (ctrl +O) и выполните обновления списка-пакетов: | Если вы обновили список репозиториев, то сохраняйте изменения в файле (ctrl +O) и выполните обновления списка-пакетов: | ||

apt-get update | apt-get update | ||

| Строка 1086: | Строка 1272: | ||

===Устанавливаем SSH в Debian=== | ===Устанавливаем SSH в Debian=== | ||

Следующим шагом установим демона openssh. Вбиваем в консоле: | Следующим шагом установим демона openssh. Вбиваем в консоле: | ||

| − | apt-get install openssh-server | + | |

| + | apt-get install openssh-server | ||

| + | |||

На предложение подтянуть недостающие зависимости отвечаем положительно. Все, на этом установка завершена и можно выполнять запуск: | На предложение подтянуть недостающие зависимости отвечаем положительно. Все, на этом установка завершена и можно выполнять запуск: | ||

| − | service ssh start | + | |

| + | service ssh start | ||

| + | |||

Теперь можно брать любой SSH-клиент и попробовать подключиться к серверу. C Windows можно использовать WinSCP. | Теперь можно брать любой SSH-клиент и попробовать подключиться к серверу. C Windows можно использовать WinSCP. | ||

| + | |||

Почему не получается подключиться к SSH под root | Почему не получается подключиться к SSH под root | ||

| + | |||

Если в качестве проверки соединения вы попробуете подключиться под root, то после отправки пароля, сервер будет постоянно ругаться и выдавать Access Denied. Сделано это намерено, т.к. нечего давать возможность подключаться root’ом к серверу. Правильней создать отдельного пользоваться, и при необходимости выполнять команды от root с помощью su. Если вы отдаете отчет своим действиям и хотите подключиться по ssh под root’ом, то тогда потребуется отредактировать конфигурационный файл службы ssh: | Если в качестве проверки соединения вы попробуете подключиться под root, то после отправки пароля, сервер будет постоянно ругаться и выдавать Access Denied. Сделано это намерено, т.к. нечего давать возможность подключаться root’ом к серверу. Правильней создать отдельного пользоваться, и при необходимости выполнять команды от root с помощью su. Если вы отдаете отчет своим действиям и хотите подключиться по ssh под root’ом, то тогда потребуется отредактировать конфигурационный файл службы ssh: | ||

| − | nano /etc/ssh/sshd_config | + | |

| + | nano /etc/ssh/sshd_config | ||

| + | |||

Находите директиву PermitRootLogin и заменяете текст после нее на yes. Должно получится так: | Находите директиву PermitRootLogin и заменяете текст после нее на yes. Должно получится так: | ||

| − | PermitRootLogin yes | + | |

| + | PermitRootLogin yes | ||

| + | |||

Сохраняйте изменения (ctrl + o) и перезапустите службу OpenSSH: | Сохраняйте изменения (ctrl + o) и перезапустите службу OpenSSH: | ||

| − | service ssh stop | + | |

| − | service ssh start | + | service ssh stop |

| + | service ssh start | ||

| + | |||

Все, после этого вы сможете подключиться к серверу с под учетной записью root. | Все, после этого вы сможете подключиться к серверу с под учетной записью root. | ||

===Как расшарить папку из консоли Linux используя Samba=== | ===Как расшарить папку из консоли Linux используя Samba=== | ||

| − | + | ||

| + | Samba - это программное обеспечение для организации обмена файлами и работы с общими ресурсами между компьютерами под управлением Linux/Unix и операционной системой Windows. Samba состоит из клиентской и серверной части. Клиентская часть позволяет получить доступ к сетевым папкам и ресурсам Windows, а серверная, в свою очередь, открывает общий доступ к папке Ubuntu для других машин, в том числе и Windows. | ||

| + | |||

Устанавливаем Самба: | Устанавливаем Самба: | ||

| − | apt-get install samba | + | |

| + | apt-get install samba | ||

| + | |||

Добавляем пару строк в конец конфига, правим при необходимости путь, имя шары, и возможность гостевого входа/записи. | Добавляем пару строк в конец конфига, правим при необходимости путь, имя шары, и возможность гостевого входа/записи. | ||

| − | nano /etc/samba/smb.conf | + | |

| − | [shara] | + | nano /etc/samba/smb.conf[shara]#имя папки |

| − | + | comment = comment_to_shara | |

| − | + | path = /home/shara #путь к папке | |

| − | comment | + | read only = no |

| − | + | locking =no | |

| − | + | guest ok = yes | |

| − | path | + | browseable=yes |

| − | + | ||

| − | |||

| − | |||

| − | read | ||

| − | |||

| − | |||

| − | locking | ||

| − | |||

| − | |||

| − | guest | ||

| − | |||

| − | |||

| − | browseable | ||

| − | |||

| − | |||

Сохраняем (ctrl+o в nano) | Сохраняем (ctrl+o в nano) | ||

| + | |||

Перезапускаем сервис с новым конфигом: | Перезапускаем сервис с новым конфигом: | ||

| − | /etc/init.d/samba restart | + | |

| + | /etc/init.d/samba restart | ||

| + | |||

Дополнительно: меняем права доступа к общей папке: (разрешено все) | Дополнительно: меняем права доступа к общей папке: (разрешено все) | ||

| − | chmod 777 /home/share | + | chmod 777 /home/share |

| + | |||

===Установка Video-server 7.0.776 в качестве ретранслятора и проброс USB в VM для ключа защиты=== | ===Установка Video-server 7.0.776 в качестве ретранслятора и проброс USB в VM для ключа защиты=== | ||

| − | + | После создания VM и установки Debian 8.6 (используем debian-8.6.0-amd64-DVD-1) без графики, необходимо закинуть папку с установщиком IV7 v7.0.776 (используя программу WinSCP от root c компьютера/ноутбука на Windows) в '''/home/videosrv7(имя пользователя)/distr''' (создать эту папку). | |

| − | /home/videosrv7(имя пользователя)/distr (создать эту папку). | + | |

| − | + | Так же необходимо скопировать все четыре reg-файла для ключей защиты с открытыми пароля от 1 до 1600 – для одного кластера. После установки видео-сервера поместить их в папку '''/home/videosrv7/video-server-7.0/''' | |

| − | + | ||

| − | + | Как зайти от root по WinSCP смотри в «Установка SSH в Debian 8.5/8.6 и доступ c другой машины под root” | |

| − | + | ||

| − | #lsusb | + | Перед установкой IV7 v7.0.776 необходимо прокинуть USB ключ с физической машины на виртуальную: |

| + | |||

| + | На ноде proxmox у которой VM c видеосервером: | ||

| + | |||

| + | #lsusb | ||

| + | |||

Ищем нужное нам устройство и смотрим его ID: XXXX:YYYY (3b13:4040) | Ищем нужное нам устройство и смотрим его ID: XXXX:YYYY (3b13:4040) | ||

| + | |||

от root | от root | ||

| − | qm set 101 –usb0 host=XXXX:YYYY (usb1: host=3b13:4040) | + | |

| + | qm set 101 –usb0 host=XXXX:YYYY (usb1: host=3b13:4040) | ||

| + | |||

где 101 — ID виртуальной машины куда будем пробрасывать порт. | где 101 — ID виртуальной машины куда будем пробрасывать порт. | ||

| + | |||

Перезагружаем VM, а затем перезагружаем ноду. | Перезагружаем VM, а затем перезагружаем ноду. | ||

| − | |||

| − | #cd /путь к папке | + | Установка же самого '''video-server-7.0.776''' стандартная, вот команды которые могут пригодится: |

| − | #./video-server-7.0.776-x64.run - запуск установки | + | |

| − | #chmod 777 -R /home/videosrv7/distr - дать права | + | #cd /путь к папке |

| − | #tar -xvzf video-server-7.0.777 - распаковка | + | #./video-server-7.0.776-x64.run - запуск установки |

| − | #rm -rf /имя папка - удаление | + | #chmod 777 -R /home/videosrv7/distr - дать права |

| − | #/etc/init.d/videosrv7 restart | + | #tar -xvzf video-server-7.0.777 - распаковка |

| − | #/etc/init.d/videosrv7 stop | + | #rm -rf /имя папка - удаление |

| − | #/etc/init.d/videosrv7 start | + | #/etc/init.d/videosrv7 restart |

| − | #/etc/init.d/keyguard restart | + | #/etc/init.d/videosrv7 stop |

| − | #nano /etc/network/interfaces | + | #/etc/init.d/videosrv7 start |

| − | #/etc/init.d/networking restart | + | #/etc/init.d/keyguard restart |

| + | #nano /etc/network/interfaces | ||

| + | #/etc/init.d/networking restart | ||

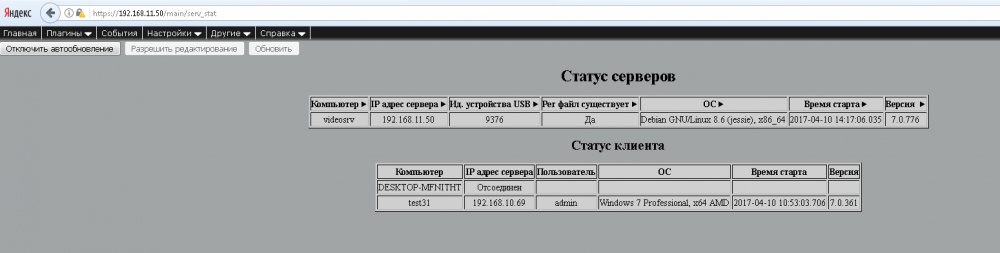

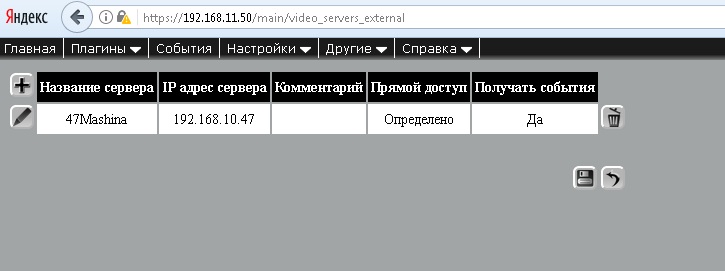

Заходим в подробный веб-интерфейс видео-сервера и убеждаемся что ключ и рег-файл определились | Заходим в подробный веб-интерфейс видео-сервера и убеждаемся что ключ и рег-файл определились | ||

| + | |||

| + | [[Файл:cl_38.jpg|центр|1000px|]] | ||

затем нужно добавить внешний видеосервер (или несколько) | затем нужно добавить внешний видеосервер (или несколько) | ||

| + | |||

| + | [[Файл:cl_39.jpg|центр|1000px|]] | ||

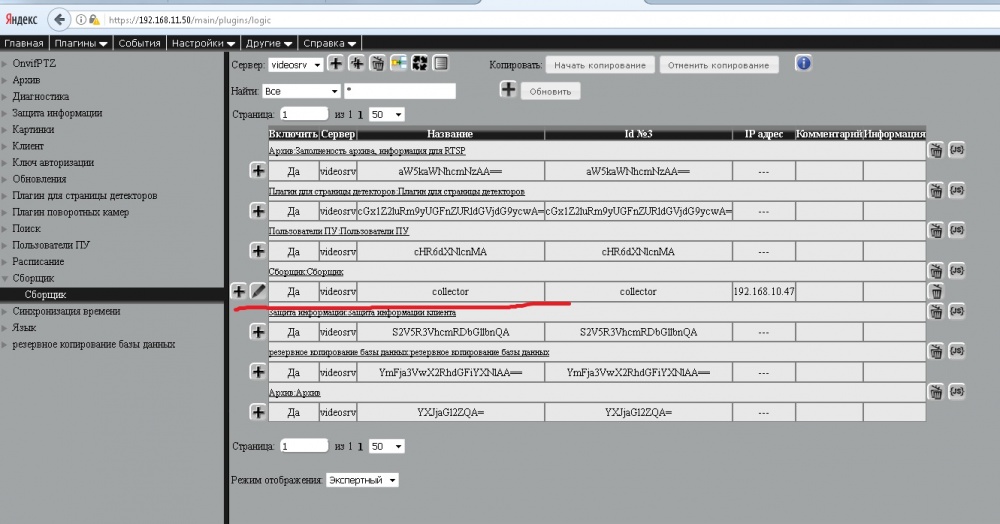

Настройки — внешние видеосервера. Затем «Плагины» - «логика» и добавляем плагин «сборщик» указав ip сервера (так же добавляем еще серверы если требуется) | Настройки — внешние видеосервера. Затем «Плагины» - «логика» и добавляем плагин «сборщик» указав ip сервера (так же добавляем еще серверы если требуется) | ||

| + | |||

| + | [[Файл:cl_40.jpg|центр|1000px|]] | ||

Это нам позволит увидеть камеры с других центральных серверов и добавить их в свои наборы. Важный момент — при создании наборы нужно добавить любую камеру, даже не существующую. Без этого наборы создать не удастся. | Это нам позволит увидеть камеры с других центральных серверов и добавить их в свои наборы. Важный момент — при создании наборы нужно добавить любую камеру, даже не существующую. Без этого наборы создать не удастся. | ||

| − | ===Установка и настройка серверной части Oracle на OS Linux (Debian 8.5/8.6)=== | + | ===Установка и настройка серверной части Oracle на OS Linux (Debian 8.5/8.6) + Клиент Oracle и клиент СКД=== |

| − | + | '''Установка Oracle 11g''' | |

| − | Установка Oracle 11g | + | |

| − | + | Перед установкой Oracle 11g R2 Express Edition (XE), нужно установить дополнительные пакеты (машина должна быть подключена к Internet). Эти пакеты могут быть установлены путем выполнения следующей команды: | |

от root | от root | ||

| Строка 1183: | Строка 1391: | ||

Перейдем в папку: | Перейдем в папку: | ||

| − | cd /usr/local/src | + | cd /usr/local/src |

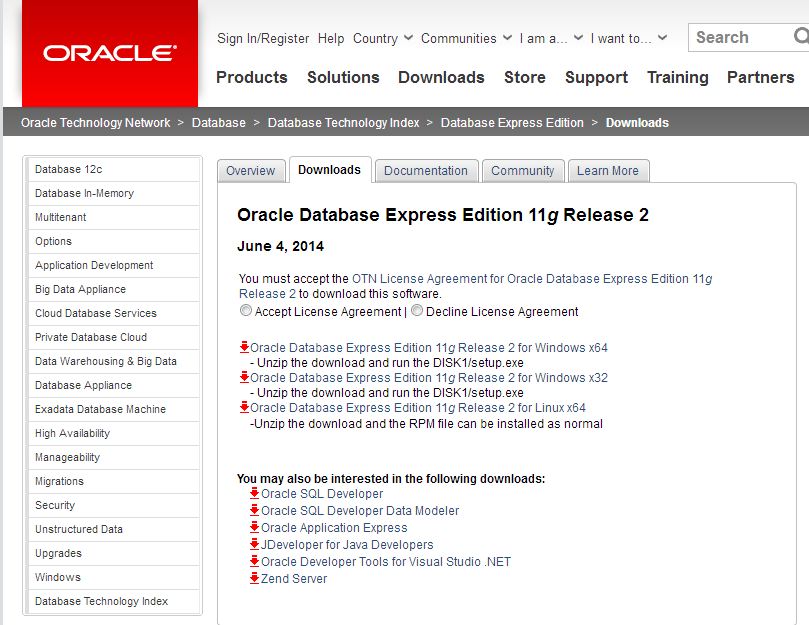

Дистрибутив oracle 11 нужно скачать с официального сайта затем нужно установить его. | Дистрибутив oracle 11 нужно скачать с официального сайта затем нужно установить его. | ||

http://www.oracle.com/technetwork/database/database-technologies/express-edition/downloads/index.html | http://www.oracle.com/technetwork/database/database-technologies/express-edition/downloads/index.html | ||

| + | [[Файл:cl_41.jpg|центр|1000px|]] | ||

Следующим шагом будет распаковка скачанного архива с оракл: | Следующим шагом будет распаковка скачанного архива с оракл: | ||

| − | unzip oracle-xe-11.2.0-1.0.x86_64.rpm.zip | + | unzip oracle-xe-11.2.0-1.0.x86_64.rpm.zip |

| − | + | Данный архив довольно большой и на распаковку потребуется некоторое время, ждем окончания и после чего переходим в нужную директорию для установки: | |

| − | cd Disk1 | + | cd Disk1 |

| − | + | Теперь мы должны преобразовать пакет Red Hat (RPM) в пакет Debian. Это может быть сделано с помощью команды alien. Параметр «-d » используется для информирования, что пакет Debian уже сформирован. Выполняем преобразование: | |

от рута | от рута | ||

| Строка 1203: | Строка 1412: | ||

alien --scripts -d oracle-xe-11.2.0-1.0.x86_64.rpm | alien --scripts -d oracle-xe-11.2.0-1.0.x86_64.rpm | ||

| − | + | Этот шаг может занять некоторое время. Потребуется подождать около 15 минут.По этому если хотите жди окончания, а можно еще открыть один терминал для работы и в нем уже выполнять следующие шаги. | |

Пакет Red Hat, полагается на файл /sbin/chkconfig, который не используется в Ubuntu. Для успешной установки Oracle XE мы используем простой трюк. | Пакет Red Hat, полагается на файл /sbin/chkconfig, который не используется в Ubuntu. Для успешной установки Oracle XE мы используем простой трюк. | ||

| Строка 1212: | Строка 1421: | ||

вставляем в открывшийся файл следующие строки | вставляем в открывшийся файл следующие строки | ||

| − | #!/bin/bash | + | #!/bin/bash |

| − | # Oracle 11gR2 XE installer chkconfig hack for Ubuntu | + | # Oracle 11gR2 XE installer chkconfig hack for Ubuntu |

| − | file=/etc/init.d/oracle-xe | + | file=/etc/init.d/oracle-xe |

| − | if [[ ! `tail -n1 $file | grep INIT` ]]; then | + | if [[ ! `tail -n1 $file | grep INIT` ]]; then |

| − | echo >> $file | + | echo >> $file |

| − | echo '### BEGIN INIT INFO' >> $file | + | echo '### BEGIN INIT INFO' >> $file |

| − | echo '# Provides: OracleXE' >> $file | + | echo '# Provides: OracleXE' >> $file |

| − | echo '# Required-Start: $remote_fs $syslog' >> $file | + | echo '# Required-Start: $remote_fs $syslog' >> $file |

| − | echo '# Required-Stop: $remote_fs $syslog' >> $file | + | echo '# Required-Stop: $remote_fs $syslog' >> $file |

| − | echo '# Default-Start: 2 3 4 5' >> $file | + | echo '# Default-Start: 2 3 4 5' >> $file |

| − | echo '# Default-Stop: 0 1 6' >> $file | + | echo '# Default-Stop: 0 1 6' >> $file |

| − | echo '# Short-Description: Oracle 11g Express Edition' >> $file | + | echo '# Short-Description: Oracle 11g Express Edition' >> $file |

| − | echo '### END INIT INFO' >> $file | + | echo '### END INIT INFO' >> $file |

| − | fi | + | fi |

| − | update-rc.d oracle-xe defaults 80 01 | + | update-rc.d oracle-xe defaults 80 01 |

| − | #EOF | + | #EOF |

Сохраните файл и закройте редактор. Теперь мы должны предоставить файл с соответствующими привилегиями исполнения. | Сохраните файл и закройте редактор. Теперь мы должны предоставить файл с соответствующими привилегиями исполнения. | ||

| Строка 1234: | Строка 1443: | ||

chmod 755 /sbin/chkconfig | chmod 755 /sbin/chkconfig | ||

| + | |||

Установим дополнительные параметры ядра. Откройте файл, выполнив: | Установим дополнительные параметры ядра. Откройте файл, выполнив: | ||

| Строка 1240: | Строка 1450: | ||

nano /etc/sysctl.d/60-oracle.conf | nano /etc/sysctl.d/60-oracle.conf | ||

| − | Скопируйте и вставьте следующий код в файле. Kernel.shmmax является максимально возможное значение физической памяти в байтах. 536870912/1024/1024 = 512 Мб. | + | Скопируйте и вставьте следующий код в файле. Kernel.shmmax является максимально возможное значение физической памяти в байтах. |

| + | |||

| + | 536870912/1024/1024 = 512 Мб. | ||

вставляем в открывшийся файл следующие строки | вставляем в открывшийся файл следующие строки | ||

| − | # Oracle 11g XE kernel parameters | + | # Oracle 11g XE kernel parameters |

| − | fs.file-max=6815744 | + | fs.file-max=6815744 |

| − | net.ipv4.ip_local_port_range=9000 65000 | + | net.ipv4.ip_local_port_range=9000 65000 |

| − | kernel.sem=250 32000 100 128 | + | kernel.sem=250 32000 100 128 |

| − | kernel.shmmax=536870912 | + | kernel.shmmax=536870912 |

Сохраните файл. Изменения в этом файле могут быть проверены командой: | Сохраните файл. Изменения в этом файле могут быть проверены командой: | ||

| Строка 1254: | Строка 1466: | ||

от рута | от рута | ||

| − | cat /etc/sysctl.d/60-oracle.conf | + | cat /etc/sysctl.d/60-oracle.conf |

| + | |||

| + | fs.file-max=6815744 | ||

| + | net.ipv4.ip_local_port_range=9000 65000 | ||

| + | kernel.sem=250 32000 100 128 | ||

| + | kernel.shmmax=536870912 | ||

| − | |||

| − | |||

| − | |||

| − | |||

это говорит о том что параметры введены верно | это говорит о том что параметры введены верно | ||

| Строка 1266: | Строка 1479: | ||

от рута | от рута | ||

| − | service procps restart | + | service procps restart |

| + | |||

Изменения могут быть вновь проверено командой: | Изменения могут быть вновь проверено командой: | ||

от рута | от рута | ||

| − | sysctl -q fs.file-max | + | sysctl -q fs.file-max |

Должны увидеть следующий вывод на экран: | Должны увидеть следующий вывод на экран: | ||

| − | fs.file-max = 6815744 | + | fs.file-max = 6815744 |

| + | |||

После этого, выполните следующие инструкции, чтобы сделать еще несколько необходимых изменений: | После этого, выполните следующие инструкции, чтобы сделать еще несколько необходимых изменений: | ||

| − | su ln -s /usr/bin/awk /bin/awk | + | su ln -s /usr/bin/awk /bin/awk |

| − | mkdir /var/lock/subsys (должен поругать и сказать,что такое файл существует,не обращаем на это внимание) | + | mkdir /var/lock/subsys (должен поругать и сказать,что такое файл существует,не обращаем на это внимание) |

| − | touch /var/lock/subsys/listener | + | touch /var/lock/subsys/listener |

| − | Теперь осталось установить уже пересобранный пакет (убедитесь в этом хорошо, а то не будет работать): | + | Теперь осталось установить уже пересобранный пакет (убедитесь в этом хорошо, а то не будет работать): |

от рута | от рута | ||

| − | dpkg --install oracle-xe_11.2.0-2_amd64.deb | + | dpkg --install oracle-xe_11.2.0-2_amd64.deb |

Происходит установка и можно перейти к настройке. | Происходит установка и можно перейти к настройке. | ||

| Строка 1295: | Строка 1510: | ||

от рута | от рута | ||

| − | rm -rf /dev/shm | + | rm -rf /dev/shm |

Создаем папку: | Создаем папку: | ||

| Строка 1301: | Строка 1516: | ||

от рута | от рута | ||

| − | mkdir /dev/shm | + | mkdir /dev/shm |

Монтируем папку для работы: | Монтируем папку для работы: | ||

| Строка 1307: | Строка 1522: | ||

от рута | от рута | ||

| − | mount -t tmpfs shmfs -o size=4096m /dev/shm | + | mount -t tmpfs shmfs -o size=4096m /dev/shm |

Создаем файл и пропишем параметры в него | Создаем файл и пропишем параметры в него | ||

| Строка 1313: | Строка 1528: | ||

от рута | от рута | ||

| − | nano /etc/rc2.d/S01shm_load | + | nano /etc/rc2.d/S01shm_load |

| − | #!/bin/sh | + | #!/bin/sh |

| − | case "$1" in | + | case "$1" in |

| − | start) mkdir /var/lock/subsys 2>/dev/null | + | start) mkdir /var/lock/subsys 2>/dev/null |

| − | touch /var/lock/subsys/listener | + | touch /var/lock/subsys/listener |

| − | rm /dev/shm 2>/dev/null | + | rm /dev/shm 2>/dev/null |

| − | mkdir /dev/shm 2>/dev/null | + | mkdir /dev/shm 2>/dev/null |

| − | mount -t tmpfs shmfs -o size=4096m /dev/shm ;; | + | mount -t tmpfs shmfs -o size=4096m /dev/shm ;; |

| − | *) echo error | + | *) echo error |

| − | exit 1 ;; | + | exit 1 ;; |

| − | esac | + | esac |

Сохраните файл, закройте редактор и предоставить соответствующие привилегии выполнения: | Сохраните файл, закройте редактор и предоставить соответствующие привилегии выполнения: | ||

| Строка 1345: | Строка 1560: | ||

от рута | от рута | ||

| − | nano /etc/bash.bashrc | + | nano /etc/bash.bashrc |

Откроется файл и в самый низ добавляем следующие строки: | Откроется файл и в самый низ добавляем следующие строки: | ||

| − | export ORACLE_HOME=/u01/app/oracle/product/11.2.0/xe | + | export ORACLE_HOME=/u01/app/oracle/product/11.2.0/xe |

| − | export ORACLE_SID=XE | + | export ORACLE_SID=XE |

| − | export NLS_LANG=`$ORACLE_HOME/bin/nls_lang.sh` | + | export NLS_LANG=`$ORACLE_HOME/bin/nls_lang.sh` |

| − | export ORACLE_BASE=/u01/app/oracle | + | export ORACLE_BASE=/u01/app/oracle |

| − | export LD_LIBRARY_PATH=$ORACLE_HOME/lib:$LD_LIBRARY_PATH | + | export LD_LIBRARY_PATH=$ORACLE_HOME/lib:$LD_LIBRARY_PATH |

| − | export PATH=$ORACLE_HOME/bin:$PATH | + | export PATH=$ORACLE_HOME/bin:$PATH |

Сохраните файл и закройте редактор. Чтобы загрузить изменения, выполните следующую инструкцию: | Сохраните файл и закройте редактор. Чтобы загрузить изменения, выполните следующую инструкцию: | ||

| − | source /etc/bash.bashrc | + | source /etc/bash.bashrc |

мы не должны увидеть ни какой ошибки | мы не должны увидеть ни какой ошибки | ||

| Строка 1364: | Строка 1579: | ||

Чтобы проверить изменения, которые вы сделали выполните: | Чтобы проверить изменения, которые вы сделали выполните: | ||

| − | echo $ORACLE_HOME | + | echo $ORACLE_HOME |

Должны увидеть следующее: | Должны увидеть следующее: | ||

| − | /u01/app/oracle/product/11.2.0/xe | + | /u01/app/oracle/product/11.2.0/xe |

После этого шага рекомендуется перезагрузить компьютер. После перезагрузки запускаем сервер с oracle: | После этого шага рекомендуется перезагрузить компьютер. После перезагрузки запускаем сервер с oracle: | ||

от рута | от рута | ||

| − | service oracle-xe start | + | service oracle-xe start |

в консоли вводим команду от рута | в консоли вводим команду от рута | ||

cd /etc | cd /etc | ||

| − | nano sudoers | + | nano sudoers |

Если нет этой папки, ее нужно создать. Или если в папке пусто, то вбиваем следующее: | Если нет этой папки, ее нужно создать. Или если в папке пусто, то вбиваем следующее: | ||

| Строка 1401: | Строка 1616: | ||

В случае успешной установки и настройки Oracle-XE мы должны увидеть следующее | В случае успешной установки и настройки Oracle-XE мы должны увидеть следующее | ||

| − | oracle-xe.service - LSB: Oracle 11g Express Edition | + | oracle-xe.service - LSB: Oracle 11g Express Edition |

| − | + | Loaded: loaded (/etc/init.d/oracle-xe) | |

| − | + | Active: active (exited) since Сб 2017-03-25 14:03:06 KRAT; 5min ago | |

| − | + | Process: 508 ExecStart=/etc/init.d/oracle-xe start (code=exited, status=0/SUCCESS) | |

| − | мар 25 14:03:05 IPE15961 oracle-xe[508]: Oracle Database 11g Express Edition is not confi...run | + | мар 25 14:03:05 IPE15961 oracle-xe[508]: Oracle Database 11g Express Edition is not confi...run |

| − | мар 25 14:03:05 IPE15961 oracle-xe[508]: '/etc/init.d/oracle-xe configure' as the root us...se. | + | мар 25 14:03:05 IPE15961 oracle-xe[508]: '/etc/init.d/oracle-xe configure' as the root us...se. |